Cuando buscás vuelos a Londres en Google y después te aparecen varias ofertas en tu perfil de Facebook no es casualidad. Cuando te aparece como sugerencia para seguir en Twitter una persona con quien tienes muchos contactos en común, tampoco. Detrás hay un algoritmo haciendo de las suyas, cogiendo la información de tus movimientos por la Red y llegando a la conclusión de qué cosas buscas, cuáles te gustan y a quién podrías conocer. El contenido y la publicidad personalizada llegan con la promesa de ofrecerte servicios que se adaptan a tus gustos y necesidades. Pero, a cambio, el algoritmo filtra cantidades inmensas de información que te estás perdiendo porque cree saber qué es lo que te interesa leer. Al tamizar el contenido que nos llega a través de las redes sociales, están también limitando nuestra visión de la realidad. En esta situación, ¿cómo puedes pensar por ti mismo cuando un algoritmo filtra lo que lees?

Lo primero y más básico es ser consciente de que esto está pasando. Y cada vez más. A principios de año, Facebook comenzó a priorizar los contenidos personales frente a las páginas de empresas y medios de comunicación. Según declaró el mismo Mark Zuckerberg, esto era "un intento de hacer comunidad", pero condicionaba el acceso de los usuarios a la información de los medios. También Instagram incluyó un sistema que decide qué publicaciones de tus contactos te muestra primero basándose en tu afinidad con tus contactos y no en la cronología.

Esto son solo los dos ejemplos más recientes y que más han dado que hablar. Paradójicamente, la Red nació para conectarnos y darnos un acceso más amplio a información más diversa, lo que podría ayudarnos a desarrollar un pensamiento más crítico y generar nuevas inquietudes. Sin embargo, con el trabajo sin descanso de los algoritmos filtrando información para nosotros, el universo al que tenemos acceso en internet se va reduciendo poco a poco y cada vez es más necesario buscar proactivamente nueva información.

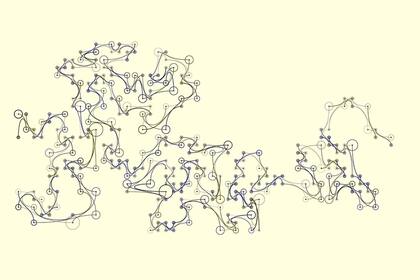

El activista Eli Pariser ya avisaba de esta burbuja que crean los filtros en 2011. "Lo que hay dentro de la burbuja que te rodea depende quién eres y qué te gusta. Pero tú no eres quien decide directamente qué entra en esa burbuja, lo hacen los algoritmos", explica Pariser. "Y lo más importante: no vemos todo lo que se elimina". Al final se refuerzan nuestras ideas preconcebidas y caemos en el error de creer que todo el mundo piensa igual que nosotros. Además, seguir solo a cuentas con las que estamos de acuerdo reafirma nuestras ideas, pero hace que nos perdamos otros puntos de vista que podrían llevarnos a conclusiones distintas y más enriquecedoras.

Lo que nos gusta, y lo que no, también

¿Cómo cambiamos esto? En este caso lo que nos interesa es que los algoritmos empiecen a mostrarnos información más diversa y no solo la que ellos creen que nos puede interesar. Una forma de conseguirlo es intentar engañarlos. Por ejemplo, siguiendo deliberadamente a personas con puntos de vista contrarios o marcas con las que no estamos necesariamente de acuerdo o que no utilizamos. Así, el algoritmo se verá obligado a ampliar horizontes y sugerirte contactos más diversos. También puedes cambiar la configuración para permitir algunas recomendaciones aleatorias (si el sistema tiene esta característica) y buscar de forma proactiva información nueva, navegar por perfiles distintos y contenido diferente: el algoritmo recogerá esa información y la reflejará en recomendaciones futuras. Otra opción para despistarlos es navegar en modo privado.

Aunque estas son algunas ideas efectivas para combatir el efecto de los algoritmos, lo cierto es que es una lucha perdida. Por eso, algunos entendidos apuestan por solucionar el problema desde dentro y proponen diseñar algoritmos que nos muestren no lo solo lo que creen que queremos ver, sino las cosas que tenemos que ver aunque no nos guste. "Si los algoritmos van a seleccionar el contenido, si van a decidir qué vemos y qué no, tenemos que asegurarnos de que no solo se guían por la relevancia, sino que también nos muestran cosas incómodas, estimulantes e importantes, otros puntos de vista", explica Pariser. "No se puede tener una democracia que funcione si los ciudadanos no acceden a un buen flujo de información, por eso necesitamos que los programadores incluyan cierta ética en los códigos que están escribiendo".