En el mundo del cine y la televisión nunca faltan estrenos que especulen sobre el lado oscuro de la inteligencia artificial y la tecnología. La temática donde el experimento sale mal y se desata el fin del los humanos es bastante popular en Hollywood. Ahora, en una investigación que suena como la trama de una película de terror, científicos del Instituto Tecnológico de Massachusetts (MIT) han alentado activamente a un algoritmo de inteligencia artificial (IA) para convertirse en un psicópata. Un psicópata llamado Norman.

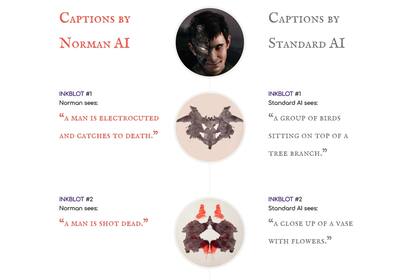

En el estudio, los investigadores Pinar Yanardag, Manuel Cebrian e Iyad Rahwan, expusieron a Norman (llamado así en honor al personaje de Anthony Perkins en Psicosis) a un flujo constante de imágenes violentas obtenidas en Reddit, luego el equipo examinó respuestas dadas por Norman al ver manchas de tinta utilizadas en una prueba psicológica de Rorschach, una prueba que se usa para detectar trastornos subyacentes del pensamiento.

Las respuestas de Norman se compararon con la reacción de otro algoritmo, uno que fue entrenado de manera estándar. En una de las pruebas, la IA estándar reportó a una persona sosteniendo un paraguas en el aire. Norman vio a un hombre muerto a balazos delante de su esposa que gritaba. En otra, donde la IA estándar vio una escena conmovedora de una pareja parada, Norman vio a una mujer embarazada caerse de un edificio. Según los investigadores, al estar constantemente expuesto a imágenes negativas y al pensamiento depresivo, la lógica de empatía de Norman simplemente no se activó.

Para los investigadores del MIT, el objetivo del estudio es probar que los algoritmos de IA no son intrínsecamente sesgados, sino que los métodos de entrada de datos y las personas que ingresan esos datos pueden alterar significativamente su comportamiento. Cuando se acusa a los algoritmos de ser imparciales o injustos, no se debe al algoritmo en sí mismo sino a los datos que han sido presentados a él.

En distintas ocasiones se han visto ejemplos de cómo la inteligencia artificial es tan buena como los datos de los que aprende. En 2015, el algoritmo de reconocimiento de imágenes de Google Photos clasificó fotos de personas de color como "gorilas" y en 2016, Microsoft lanzó Tay, un chatbot de Twitter que Microsoft dijo ser un experimento social, cultural y técnico, pero al que los usuarios de Twitter provocaron para que dijera cosas racistas e inapropiadas, y funcionó.

El siguiente paso del equipo del MIT es constatar que Norman puede ser reeducado. Para esto han creado un formulario donde las personas pueden participar en interpretaciones más positivas de las manchas de tinta de Rorschach para mitigar el estado mental oscuro y macabro de Norman, lo cual será posible a través del aprendizaje de los comentarios humanos. En el formulario, podemos tomar la misma prueba de transferencia de tinta para agregar nuestras respuestas al conjunto de datos y así ayudar a Norman. De acuerdo con un reporte de la BBC, los investigadores a la fecha ya han recibido más de 170.000 respuestas a esta prueba.

Otras noticias de Inteligencia artificial

1

1SwagBot: así es el vaquero robot que busca revolucionar la ganadería

2

2Cómo activar el “modo Mar del Plata” en WhatsApp

3

3Las mejores 150 frases para saludar por el Año Nuevo 2025 a través de WhatsApp e Instagram

4

4Un accidente entre vehículos autónomos, una gran postal para ilustrar la tecnología de 2024