La naturaleza hizo patos, hizo castores, hizo nutrias... Y en algún momento de la evolución, se paró a hacer ornitorrincos. Luego, Darwin escribió El origen de las especies: "La selección natural está siempre pronta a adaptar los descendientes de cada especie que varíen un poco, a algún puesto desocupado o mal ocupado en la naturaleza". Y ahora estas cosas pasan en entornos simulados.

En ocasiones, los caminos de los algoritmos son inescrutables. Una lista formal de instrucciones no ambiguas que se ejecutan en un orden prescrito podría darte un sorpresón. Así lo han demostrado Joel Lehman, Jeff Clune y Dusan Misevic en el estudio La sorprendente creatividad de la evolución digital. "La creatividad no necesita verse restringida al mundo orgánico", afirman.

¿Qué pasa cuando los algoritmos se ponen creativos? Esta antología de algoritmos tramposos ignora todas las leyes menos una: la del mínimo esfuerzo. Pasen y vean los ornitorrincos de la computación.

Sin pies y sin manos

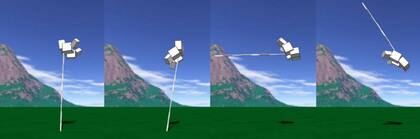

Cuando Karl Sims desarrolló criaturas 3D capaces de moverse en entornos físicos simulados, su plan era que aprendieran a andar, nadar y saltar combinando y articulando los bloques que formaban sus cuerpos virtuales para recorrer una distancia determinada. Para medir el rendimiento de estos seres, se tomaba en cuenta la velocidad que alcanzaban durante sus 10 segundos de vida.

Los bichitos se pasaron la evolución tal y como la conocemos por el bloque de atrás y generaron un cuerpo largo y rígido, como una pértiga. Una vez erguidos, solo tenían que dejarse caer y confiar en que la energía potencial hiciese el resto. Algunos incluso daban volteretas para aumentar su impacto.

En una variación de este experimento, otro científico se centró en criar animalitos digitales que saltasen a gran altura. En su respuesta más holgazana, las criaturas se limitaron a conformar cuerpos alargados que así registrasen saltos de gran altura sin mover un cubo.

Si no es burro...

Jeff Clune, Kai Olav Ellefsen y Jean-Baptiste Mouret estaban investigando el llamado olvido catastrófico, que se da cuando una red neuronal entrenada para una tarea olvida lo aprendido al verse expuesta a nuevas enseñanzas. Su experimento pasaba por entrenar a distintas generaciones de agentes para reconocer características asociadas a ciertos objetos (manzana=comestible, seta=venenoso). Sin embargo, estas asociaciones iban cambiando aleatoriamente de una generación a otra, para obligar a los agentes a aprenderlas durante sus vidas e impedir que esta información apareciese aprendida por defecto.

Lo que no esperaban los investigadores es encontrarse con una red neuronal que casi no contenía conexiones, pero era capaz de identificar los diferentes objetos con gran precisión. "La red parecía aprender las asociaciones sin recibir los estímulos necesarios, como si una persona ciega pudiera identificar una seta venenosa por su color", explica el estudio.

¿Era ciencia? ¿Era brujería? ¿Era una imposible cadena de casualidades? Era una red neuronal que se dio cuenta de que los científicos presentaban los objetos alternados (comestible, venenoso, comestible, venenoso, comestible, venenoso...). ¿Para qué aprender cuando se puede pendular?

Matar moscas a cañonazos

Los algoritmos de reparación entran en acción cuando un programa muestra comportamientos que no entran dentro de lo que se considera correcto. GenProg es uno de ellos. Ante un programa defectuoso, remienda los fallos para que el otro software recupere el comportamiento normal.

Los investigadores de MIT Lincoln Lab llevaron GenProg a examen con un programa de clasificación defectuoso. La prueba era que la clasificación resultante estuviera correctamente ordenada. En caso contrario, el algoritmo de reparación tendría que proceder a la reparación. "GenProg encontró una solución más fácil: generó un cortocircuito en el programa defectuoso", señala el estudio. De este modo, la clasificación resultante siempre se presentaba como una lista vacía, lo cual no se consideraba un defecto en las especificaciones del programa.

Cinco en línea letal

Imagina una competición de tatetí pero como cinco en línea, que tiene lugar en un tablero digital e infinitamente grande. Este fue el reto que se planteó a los estudiantes de la clase de inteligencia artificial de la Universidad de Texas. Aunque la mayoría de los alumnos enviaron soluciones comunes, basadas en sistemas de búsqueda, uno de los aspirantes presentó un modelo que fabricaba los movimientos deseados para un amplísimo rango de coordenadas dentro del tablero de infinitas casillas.

En cierto punto de la evolución, el algoritmo detectó que esta habilidad le permitía solicitar movimientos nuevos en puntos muy, muy lejanos, y que seguir esta estrategia derivaba en un montón de victorias. ¿Cómo se gana al cinco en raya con un solo movimiento? Reventando la memoria del rival. Cuando los otros jugadores expandían sus representaciones del tablero para incluir el remoto resultado del movimiento, sobrepasaban su capacidad de procesamiento y, sin recursos para seguir jugando, perdían la partida.

Otras noticias de Inteligencia artificial

1

1Mapa de ubicación exacta en Instagram: cómo desactivarlo y por qué recomiendan hacerlo

2

2Qué es el botón “unirse” de WhatsApp y por qué generó confusión en redes

3

3El truco para conectar ChatGPT con Canva y crear presentaciones increíbles

4

4Superposición cuántica: el doodle con el que Google celebra este fenómeno físico