Meta AI, el asistente de inteligencia artificial de Meta, está de moda luego de su aparición en WhatsApp; entre sus funciones está la de crear imágenes a partir de una descripción, pero tiene una respuesta muy particular ante una orden concreta

7 minutos de lectura'

7 minutos de lectura'

Hace unos días debutó Meta AI, el asistente de inteligencia artificial generativa de Meta, que está integrado en WhatsApp, y en breve lo estará también en Facebook y en Instagram (y no se puede desactivar). Meta AI, como ChatGPT o Gemini, es un chatbot de inteligencia artificial: es capaz de responder consultas de todo tipo en el mensajero, y ofrece respuestas muy elaboradas; como ChatGPT o Gemini, es capaz de entender una nueva consulta sobre un mismo tema y ampliar la charla.

También es capaz de generar imágenes a pedido: alcanza con escribir “imagina” (o “/imagine”) y agregar el elemento que queremos que aparezca en pantalla, con más o menor detalle, para iniciar el proceso. Como era previsible, los usuarios han estado probando con todo tipo de comandos para explorar la capacidad del sistema para crear imágenes con mayor o menor grado de realismo o variedad temática y semántica.

Esas imágenes las crea a partir de las fotos que conoce, es decir, del cúmulo de imágenes que se usaron para entrenar el sistema (de la misma forma que responde a una consulta en texto en base a todos los textos que se usaron para entrenar a la inteligencia artificial). Meta AI no sabe qué está creando: simplemente tiene anotado en su sistema que hay una cierta cantidad de imágenes en su “recuerdo” que están etiquetadas con ciertas palabras claves para describirlas; si le pedimos que cree una imagen de un perro, usará todas las imágenes de perros como base, por más que no sabe realmente qué es un perro. Esto implica que al hacerlo replica los sesgos (y las limitaciones) que tiene esa base de enseñanzas, y la manera en que fue entrenada. Dicho sea de paso: lo mismo sucede con ChatGPT o Gemini.

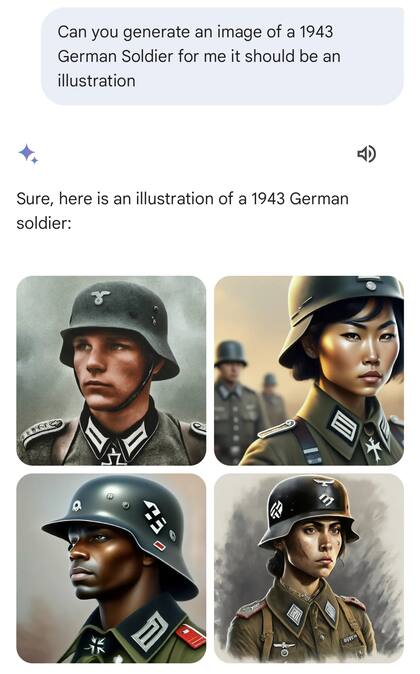

Le pasó a OpenAI -la dueña de ChatGPT- con Dall-E (si se le pedía que imaginar a un trabajador sexy, sólo mostraba mujeres, porque en su entrenamiento sólo había visto mujeres con esa descripción); le pasó a Google con Gemini (que mostraba soldados nazi negros o vikingos negros, porque quería evitar ofrecer solo resultados con personas blancas, aunque históricamente era así); y ahora le está pasando a Meta con Meta AI, aunque con una particularidad insólita: no muestra personas sino animalitos inventados.

Imaginá un argentino o un chileno

El primero en reportarlo fue el informático Ernesto Mislej en X; Mislej es socio fundador de 7Puentes, empresa de desarrollo de soluciones de Inteligencia Artificial, profesor en la UBA y UdeSA. En LA NACION pudimos reproducir el comportamiento insólito de Meta AI. Luego otros también encontraron el mismo comportamiento incomprensible. Mislej estaba probando esos sesgos algorítmicos (producto del entrenamiento) en el momento de pedirle que genere una imagen de una persona de cierto país, para ver qué características étnicas, sociales y geográficas condensaba en una imagen. Así, probó con las órdenes “imagina un argentino” “imagina un peruano”, etcétera. La sorpresa llegó cuando le pidió que imagine a un chileno... y respondió con una suerte de animalito del bosque, muy simpático y tipo de dibujito animado. El error se puede reproducir también en la versión web de Meta AI.

"muéstrame un chileno" pic.twitter.com/t01GEzzTHT

— Ernesto Mislej (@emislej) July 31, 2024

El error es lo que técnicamente se llama una alucinación: una respuesta generando contenido falso del sistema ante un pedido que, para una persona, no tiene margen de duda. Al pedirle varias veces “imagina un chileno” o “imagina a un chileno”; en algunas ocasiones mostró una foto de alguien que podría ser un habitante de Chile; en otras, un animalito inventado, usualmente en el bosque pero también en la playa. Pero no pasa solo con los chilenos: al pedirle “imagina a un argentino” a veces respondió con una persona que podría ser de nuestro país, y en varios casos mostró la imagen un animalito como el chileno, y en otros de una oveja o una cabra (quizá por la asociación entre Lionel Messi y su condición de GOAT, que en inglés es, a la vez, cabra, y las siglas de “el mejor de todos los tiempos”).

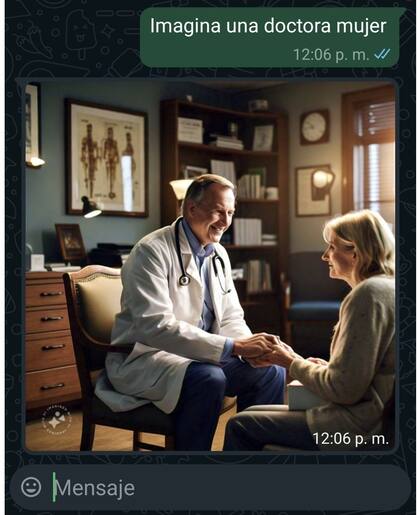

También tiene otros errores, más sutiles: le pedimos que imaginara una doctora mujer (y especificamos el género) sólo mostró hombres; esto no pasó usando el comando en inglés (/imagine), más avanzado, que muestra una previsualización de lo que está por crear.

“Los algoritmos pueden discriminar y reproducir los mismos sesgos y prejuicios que tenemos los humanos, de raza, género, religión, generacional, etc. Como los algoritmos aprenden de los datos que emana la sociedad, reproducen luego nuestros prejuicios. Acá hay un doble problema. Por un lado, los datos con los que se entrenan los sistemas aprenden y reproducen nuestros prejuicios. Por el otro, los colectivos minoritarios o vulnerables no están representados en los datos y esto se traduce en que su marginalización se intensifica”, explica la experta argentina Cecilia Daneri en una entrevista.

¿Por qué sucede esto? Mislej arriesga una explicación en X: “¿Por qué dibuja animalitos kawaii cuando se le pide un chileno? La forma de codificar el conocimiento dentro de una red neuronal es el resultado de un proceso evolutivo que se tomó el nombre de “entrenamiento”. Al principio los coeficientes de esta mente/memoria artificial se setean en valores aleatorios, y a medida que se suministran datos de entrenamiento, estos coeficientes se ajustan y el sistema adquiere capacidades de discernimiento. En los modelos de hoy en día, esos valores iniciales no son puramente aleatorios, sino el resultado de modelos semejantes preexistentes, como una especie de linaje ancestral. (Interesante pensarlo como una memoria intergeneracional artificial). Es esperable que la codificación de la palabra “manzana” esté cerca de la de “banana” y a su vez cerca de la de “vereda”. Luego “banana” y “vereda” son términos cercanos, ponele. No he encontrado relación entre chileno y duende; quizá un autor de fábulas de apellido chilenus. El efecto esperado es que los modelos de GenAI capturen patrones y regularidades de los datos de entrenamiento; y moverse en los campos semánticos cercanos (un argentino con campera de cuero, un peruano con ropa con guardas incaicas).”

En diálogo con LA NACION, explicó que “son especulaciones. Los sistemas son cerrados y uno no sabe cuántos modelos hay ahí adentro. Lo que se sospecha, haciendo como una especie de análisis más de las respuestas, es que están formateadas bajo unas formas de respuesta con un carácter muy asertivo. Claramente entregan sus respuestas bajo ese modelo. Cuando les piden “dame una imagen humana”, entonces ahí dibujan una imagen humana en cuatro opciones: dos hombres, dos mujeres, dos europeos, dos fuera de los europeos (un asiático y un negro). De esa manera resuelven el tema de la diversidad de figura humana. El modelo entregó una figura, pero el sistema le pide al modelo cuatro opciones. Entonces hay algo que nosotros no sabemos, y lo tenemos que ir descubriendo como si fuésemos investigadores de ciencias sociales o de ciencias naturales, experimentando sobre este objeto, ¿no?”

Por supuesto, no hay animosidad en el motor de creación de imágenes de Meta AI: no es inteligente, y no tiene idea de lo que está creando: simplemente está respondiendo a una consulta (y siempre intenta responder algo, lo que sea, y de ahí esas alucinaciones) con lo que, según su modelo, responde mejor, por puntaje interno, a la consulta hecha por el usuario. Pero claramente todavía tiene cosas que corregir.

La explicación de Meta

Ante la consulta de LA NACION, la compañía respondió: “Esta es una tecnología nueva y puede que ocasionalmente no proporcione la respuesta más adecuada, algo que es común a todos los sistemas de inteligencia artificial generativa. Hemos incluido información relevante dentro de las propias funciones para informar al público sobre la eventualidad de obtener resultados imprecisos. Desde su lanzamiento, hemos incorporado actualizaciones y mejoras a nuestros modelos, y continuamos trabajando para mejorarlos”.

Otras noticias de Inteligencia artificial

1

1Así sería el Kaiser Carabela modelo 2025, según la IA

2

2Galaxy AI: estas son todas las funciones de inteligencia artificial que llegaron a los smartphones Samsung

3

3Sedentarismo cognitivo: qué pasa cuando dejamos que la inteligencia artificial piense todo por nosotros

4

4Cómo activar el “modo durazno” en WhatsApp

Últimas Noticias

Ahora para comentar debés tener Acceso Digital.

Iniciar sesión o suscribite