La era de los álbumes de fotos inteligentes ya está aquí

Cómo funcionan los servicios de Google, Microsoft y Flickr que son capaces de detectar y organizar qué tipo de fotos guardamos

El volumen de fotografías digitales que tomamos con las cámaras, las tabletas y los smartphones es tan grande, que organizarlas por categoría y con sus respectivas etiquetas puede ser un trabajo tan largo como tedioso. Y encontrar más tarde una foto específica, algo similar a hallar la proverbial aguja en el pajar.

Para acelerar este proceso, varios servicios de almacenamiento de imágenes han desarrollado sistemas de reconocimiento automático de objetos. De esta manera, la solución reconoce y clasifica lo que observa, ya que detecta si lo fotografiado es un perro, un paisaje o un mueble, entre millones de opciones.

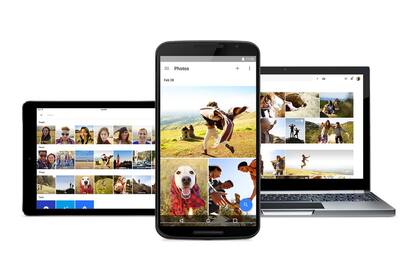

Ayer Google presentó Photos, una aplicación para Android y iOS que se vinculan con un servicio Web que permite esto: organizar fotos en según quién está en ellas, dónde fueron tomadas, cuándo o qué tipo de objeto aparece en ellas (si es la foto de un perro, de un plato de comida, de un paisaje, un edificio, etcétera). Incluso puede determinar el lugar en que se tomó la foto sin los datos geográficos, ya que reconoce el lugar (si es un espacio público).

Las ventajas que ofrecen estas innovaciones son muchas, ya que simplifican la forma de buscar, visualizar, gestionar y compartir fotos, de las que cada vez tenemos más.

"Para realizar esta tarea que parecería trivial para un ser humano, es necesario aplicar recientes descubrimientos en procesamiento de imágenes, sustentados por los trabajos de investigaciones de los últimos 40 años en la historia de esta disciplina llamada Visión Artificial", apunta Pablo Negri, Profesor Investigador de la Facultad de Ingeniería y Ciencias Exactas de UADE que, además de ser Doctor en Robótica y especialista en visión artificial, es investigador del CONICET y enseña en la materia de posgrado "Procesamiento de imágenes" en dicha universidad.

Por ejemplo, el servicio OneDrive, de Microsoft, permite almacenar y buscar fotos por su etiqueta, tanto las que crearon los usuarios, como las aplicadas en forma automática por los algoritmos que analizan las imágenes. Algo similar está disponible en el álbum de fotos Flickr, que recientemente presentó una nueva versión, capaz de ordenar las fotos de manera automática y separar imágenes por categorías como animales, comida, arquitectura y vehículos, entre otros, además de elegir imágenes con ciertos colores presentes, orientaciones, etcétera.

A los avances que están realizando en este campo distintas firmas como IBM y Google, se suma Wolfram Research, una organización dedicada a la investigación y el desarrollo de software, y que está detrás del buscador Wolfram Alpha. En el blog de su fundador y CEO, Steven Wolfram, anunció recientemente el lanzamiento de The Wolfram Language Imagen Identification Project mediante el cual el usuario puede arrastrar cualquier imagen hasta el centro de este website para que el sistema lo reconozca automáticamente que muestra la foto. Además, debajo de la etiqueta presenta la definición del objeto detectado.

Aprendiendo a mirar

¿Cómo hacen estos sistemas para saber que la foto muestra a un perro en lugar de una casa? "En todos los casos se trata de programas que tienen la capacidad de aprender. Gracias a la inmensa capacidad de procesamiento de las computadoras, los sistemas pueden comparar la imagen de un objeto con otros miles en cuestión de segundos. De esta manera, pueden identificar que aquello de cuatro patas es un perro y no una mesa, por ejemplo", explica Juan José D'Alessandro, gerente de negocios de la firma global de servicios orientados a IT Softtek, compañía que participó a nivel regional de varias licitaciones vinculadas al desarrollo de programas de reconocimiento de datos biométricos para cédulas de identidad y pasaportes.

"Primero, el servicio le solicita al software que agrupe imágenes de un mismo objeto y que busque patrones de similitud mediante repetición -explica-. Por ende, el programa realiza por sí solo este trabajo, y así aprende a reconocer objetos para etiquetarlos correctamente y no confundirlos con otros similares". Para efectuar esta tarea, cada proveedor desarrolla sus propios algoritmos que auto-resuelven esta instancia de una manera mucho más rápida y económica que lo que implicaría contratar a humanos que categoricen cada objeto.

Un punto clave es que los programas desintegran cada imagen para analizar. Como comenta Negri, "el funcionamiento de estos sistemas se basa en extraer toda la información posible de la imagen. Su menor (y única) unidad de información son los píxeles, que son aquellos cuadraditos que es posible descubrir haciendo varias veces zoom en una foto. El dato que aporta el pixel es una medida del color que el sensor de la cámara identificó en ese lugar de la escena. Por supuesto que esto no representa mucha información. Sin embargo, lo importante no es analizar un pixel solito sino las relaciones que podemos hacer entre él y los otros píxeles de la imagen. Ahí está el secreto de los sistemas de reconocimiento".

Un ejemplo: para entrenar al software a fin de que reconozca un objeto, se debe mostrar una gran cantidad de imágenes con la mayor diversidad posible: montañas con nieve, sin nieve, con árboles, etc. Luego, cuando se encuentre una configuración de píxeles de ciertos colores y que tengan tal o cual forma, el sistema responde que su apariencia se asemeja a una montaña. "El sistema interpreta así las relaciones entre los píxeles de la imagen para sacar conclusiones", indica el docente de UADE.

¿Y ahora qué?

En la actualidad se realizan enormes esfuerzos de la comunidad científica para resolver este tema, proponiéndose continuamente desafíos que hasta hace algunos años parecerían imposibles de lograr. En Google hay investigadores trabajando en mejorar la detección de objetos, su clasificación y etiquetado en una escena compleja, es decir, cuando aparecen varios objetos en una misma fotografía, en base tecnología vinculada con el procesamiento del lenguaje natural para que el software pueda presentar una descripción completa de la imagen. Este tipo de sistema podría eventualmente ayudar a las personas con discapacidad visual a entender las imágenes, ya que éstas podrían incluir un texto explicativo de lo que se ve.

Para Google Photos, Flickr y, en menor medida, Microsoft OneDrive, la riqueza está en el buscador: estos servicios organizan fotos elementos comunes clásicos (personas, lugares específicos), pero también permiten encontrar fotos a partir de una palabra clave (gatos, gente saltando, durmiendo, un plato, una torre), permitiendo recuperar imágenes que a veces ya ni recordábamos que teníamos.

Pero estos algoritmos no están ajenos al error: y pueden confundir, todavía, una cosa por otra, pero su capacidad para procesar y analizar millones de fotos permite ir saldando esa deficiencia.

D'Alessandro explica que a medida que se incrementa la base de datos de imágenes sobre la cual se establecen los patrones, aumenta la precisión del sistema al etiquetar lo que aparece en la foto. Por este motivo, estas soluciones mejorarán la performance de sus algoritmos con el paso del tiempo. Por lo pronto, estas propuestas aún tienen mucho por evolucionar: "El etiquetado humano no va a ser reemplazado por el momento ya que estos servicios aún no podrían detectar ciertas imágenes, por ejemplo, distinguir a una persona disfrazada o cambios abruptos de fisonomía", aclara, y advierte que a medida que los investigadores avancen en el campo de la inteligencia artificial para que las computadoras puedan emular el cerebro de los humanos, estas cuestiones quedarán resueltas.

lanacionarOtras noticias de Internet

Más leídas de Tecnología

Clave. Los trucos de WhatsApp más simples y prácticos que son fáciles de aplicar

Infancias. Cómo activar el "modo Peter Pan" en WhatsApp

Similares a los Ray-ban de Meta. Samsung tendrá su línea de anteojos inteligentes en 2025

Cuidado. Qué significa quitar la foto de perfil en WhatsApp, según un psicólogo