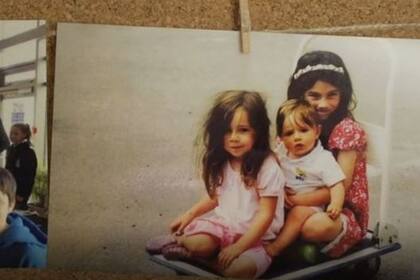

"Molly era la pequeña de tres hermanas. Tenía 14 años y era una adolescente normal. Era entusiasta. Esa noche acabó los deberes y preparó la mochila para ir a la escuela. Cuando nos despertamos a la mañana siguiente, estaba muerta".

A Ian Russell se le quiebra la voz. Es el padre de Molly, una chica inglesa de 14 años que se suicidó en 2017.

"Es muy triste. En solo un instante te das cuenta de que tu vida nunca volverá a ser igual", explica.

"Molly dejó notas. Tenemos suerte de tener notas suyas después de que muriera, porque intentó explicarnos cómo se sentía", cuenta.

"Algunas de las notas decían: 'Soy el problema de la vida de todos. Los quiero a todos. Sean fuertes. Estoy orgullosa de ustedes".

Tras su muerte, la familia indagó en las cuentas de las redes sociales que Molly seguía, y encontró contenido sobre la depresión y las autolesiones.

"No tengo ninguna duda de que Instagram ayudó a matar a mi hija", denuncia Russell ahora.

Según datos de la Organización Mundial de la Salud, en 2016 se suicidaron en todo el mundo más de 200.000 personas de entre 10 y 29 años.

"Mi hija tenía mucho por ofrecer. Y todo se esfumó. Tenemos que aceptarlo. Lo duro es que todo se esfumó con la ayuda de internet y las redes sociales".

El contenido de las redes sociales

El padre explica que decidieron investigar las redes sociales en las que Molly tenía cuenta.

"Me acuerdo de encontrar un dibujo con una leyenda: 'Este mundo es muy cruel, ya no quiero verlo más'", explica.

"Había cuentas de gente que estaba deprimida, que se autolesionaba o que se planteaba el suicidio. Molly había accedido a muchos contenidos parecidos", añade.

Ian afirma que una parte de los materiales eran positivos, de grupos de personas que intentaban ayudarse entre ellas, mantener una actitud positiva y dejar de autolesionarse.

Pero explica: "Otra parte del contenido es estremecedor, anima a autolesionarse y relaciona las autolesiones con el suicidio".

La BBC buscó en Instagram el contenido que aparecía con el "hashtag" (etiqueta) de "selfharm" (autolesión, en inglés) y encontró imágenes muy explícitas de los usuarios.

Además, los "hashtags" ayudan a encontrar más contenido similar, ya que los usuarios se pueden suscribir y seguir las publicaciones que tienen una etiqueta en particular.

El contenido con la etiqueta de "depression" (depresión) conduce a material lúgubre, como videos sobre suicidios.

"Las publicaciones de estas cuentas suelen ser en blanco y negro. Son fatalistas, no dejan lugar a la esperanza. Es como decir: únete al grupo. Tú estás deprimido, yo también, somos muchos", explica el padre de Molly.

"No nos podíamos imaginar que este tipo de contenido pudiera estar en una plataforma como Instagram. Y todavía está ahí, es muy fácil de encontrar, no está escondido. Está disponible", añade.

El papel de los algoritmos

Ged Flynn es el director de Papyrus, una organización para la prevención del suicidio entre jóvenes que se fundó en Reino Unido en 1997.

En una entrevista, la BBC le mostró a Flynn las imágenes que había encontrado en Instagram.

"Iba a decir que no estoy sorprendido, pero lo estoy. El suicidio no es un 'hashtag'. Es una tragedia inimaginable y devastadora", asegura Flynn.

Hay un problema añadido: los algoritmos de Instagram ayudan a los usuarios a localizar contenido relacionado. Al seguir una cuenta de este tipo, la red social te sugiere más.

"Si un algoritmo de una red social está programado para ofrecer más contenido del mismo tipo que se ha buscado, en ciertos casos tiene que ser más cuidadoso que cuando se busca, por ejemplo, el término 'flores'", explica Flynn.

Y añade: "Las leyes sobre el suicidio son muy claras: animar a alguien a acabar con su vida es ilegal. Ya sea en Internet o en la vida real, ya sea con palabras o con imágenes, cualquiera que te sugiera que deberías hacerlo es, como mínimo, un cómplice potencial".

"Instagram debe plantearse seriamente cambiar sus algoritmos para salvar vidas. Y lo tiene que hacer ya", dice.

La respuesta de Instagram

La BBC intentó entrevistar a responsables de Instagram, que declinaron la propuesta pero emitieron un comunicado.

"No permitimos contenido que promueva o idealice los trastornos alimenticios, las autolesiones o el suicidio. Eliminamos el contenido de este tipo", afirman en la nota.

Instagram sí cuenta con una herramienta que advierte sobre ciertos términos de búsqueda y ofrece ayuda.

Pero los usuarios pueden, simplemente, rechazar la ayuda y seguir navegando.

Papyrus, que opera en el Reino Unido, proporciona información y asesoramiento práctico a cualquier persona joven que tenga impulsos suicidas.

Todos los miembros del consejo de administración de la organización fueron personalmente afectados por el suicidio. Muchos perdieron a un hijo por suicidio.

"No está bien que un niño pueda acceder a este tipo de imágenes tan explícitas. Las redes sociales no pueden seguir argumentando, por ejemplo, que tienen un botón que ofrece ayuda si el algoritmo detecta que se buscaron términos como 'autolesión' y 'suicidio' tres o cuatro veces", explica Flynn.

"Mi mensaje sería que se lo tomen seriamente. El suicidio es la principal causa de muerte en jóvenes en Reino Unido. ¿Hasta dónde tiene que llegar para que se haga algo?", añade.

El gobierno británico está instando a las redes sociales a asumir más responsabilidad respecto al contenido que ilustra y promueve métodos de suicidio y autolesión.

"Devastador" y "complicado"

Después del comunicado de Instagram, Steve Hatch, director de Facebook -la compañía a la que pertenece Instagram- para Europa del Norte, le contó a la BBC en una entrevista en exclusiva que la muerte de Molly Russell fue un "suceso devastador".

Hatch le dijo al editor de la BBC Amol Rajan que se sintió "profundamente afligido" cuando escuchó las acusaciones del padre de Molly en las que aseguró que la red social es, en parte, responsable de la muerte de la niña.

"No me puedo ni imaginar cómo se siente el padre de Molly y el resto de la familia", declaró.

Cuando Rajan le mostró imágenes de autolesiones que supuestamente van en contra de las políticas de Instagram, pero, aún así, disponibles en la red social, el ejecutivo respondió lo siguiente: "Tenemos que asegurarnos de que analizamos estas imágenes y nos aseguramos de que son eliminadas".

Hatch también dijo que Instagram revisa sus políticas constantemente en todo lo relacionado con imágenes sobre depresión y suicido.

"Es un asunto muy complicado", añadió.

"Trabajamos con expertos que ayudan a diseñar las políticas sobre las imágenes de autolesiones. Es un área muy compleja".

"Los expertos nos dice que cuando esas imágenes son publicadas por personas que están pasando, claramente, por una situación muy difícil, muchas veces lo hacen porque buscan apoyo o ayuda".

"En esos casos, puede ser muy útil y de mucha ayuda que esas imágenes estén disponibles en la plataforma. Por eso las permitimos y ofrecemos apoyo a quienes las puedan ver".

"Lo que no permitimos son las que aplauden o ensalzan (el suicidio)".

No quiso, sin embargo, responder a la pregunta de si permite a sus hijos usar Instagram, pero señaló que la red social "trabaja duro" en eliminar ese tipo de imágenes y que también ofrece "mucho apoyo" a la gente.

BBC Mundo

BBC MundoOtras noticias de Instagram

1

1Renault Gordini modelo 2025: así sería el histórico vehículo, según la IA

2

2Histórico: China repavimentó casi 160 km de autopista con máquinas autónomas

3

3Se termina el Impuesto PAIS: cuánto costará un iPhone en el exterior desde diciembre 2024

4

4Las 5 señales que muestran que tenés una mentalidad positiva, según un análisis de IA