Google quiere que dejes de buscar en la web, pero seguir respondiendo a todas tus preguntas

Las nuevas herramientas que presentó esta semana permiten hacer consultas de todo tipo y recibir respuestas a medida, incluso si son muy complejas, gracias a la inteligencia artificial, y sin que tengas que irte a otra página web a terminar de juntar información

8 minutos de lectura'

8 minutos de lectura'

El martes, durante la conferencia de apertura del Google I/O 2024 (el evento anual para desarrolladores de la compañía), Google hizo una serie de anuncios sobre el futuro de las búsquedas en la web, la herramienta que hace algo más de un cuarto de siglo inició el camino para transformar a Google en lo que es hoy.

Una de las más espectaculares -pero todavía en desarrollo- tiene que ver con las búsquedas visuales. Hasta ahora, “buscar en Google” (o googlear, directamente) implicaba anotar una serie de palabras clave, o una frase, en la caja de búsqueda, que devolvía, en sus inicios, una lista de sitios que contenían esas palabras o frases (con una flexibilidad creciente, a medida que Google fue modificando el algoritmo para que no fuera tan literal). En esa lista hoy figuran, también, los sitios que pagaron por estar ahí (sean relevantes o no a la búsqueda) o que generan contenido específicamente para figurar en la lista (una práctica conocida como SEO, las siglas en inglés de optimización para motores de búsqueda), y a los que muchas veces hay que vadear para llegar a tierra firme, es decir, a esa página donde está el contenido que buscábamos.

Del texto a la voz, y luego a la imagen

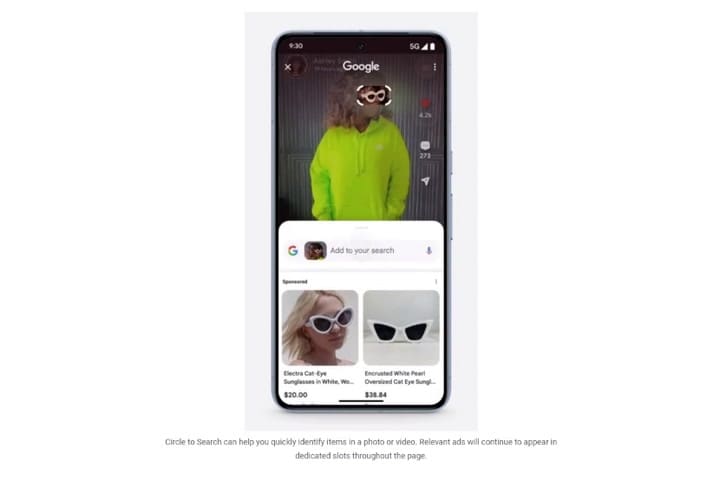

Con la llegada de los smartphones, Google añadió la búsqueda por voz (que reemplaza el tipear por el decir en voz alta la frase que buscamos), y luego la búsqueda por imágenes, a medida que sus sistemas de reconocimiento visual se iban haciendo más sofisticados. Primero con Google Lens, hace algo más de un lustro, y en enero último con “enlazar para buscar” (circle to search, en inglés), una función disponible en los últimos teléfonos Pixel 8 y 8 Pro, y en los Galaxy S24, S23, S22 y S21, y los plegables de Samsung de los últimos años. ¿De qué se trata? De tomar una fotografía -o hacer una captura de pantalla- y destacar, con el dedo, el elemento de la imagen sobre el que queremos más información, incluso si no sabemos cómo se llama: en vez de ir describiendo el elemento (un par de anteojos blancos, de los que puede haber miles, todos parecidos, o una lámpara que parece un perro, que quizá no se llama como creemos), dejamos que Google lo identifique usando sus herramientas de análisis de imágenes. No hace magia, pero funciona muy bien.

Así funciona Circle to Search

Buscar sin saber

El martes, la compañía mostró que está preparando una herramienta adicional, que cumple la misma función (pedir más información sobre algo que está en pantalla, sin necesidad de nombrarlo), pero con la ventaja de que se puede hacer en video, con la cámara del teléfono, en el momento, y haciendo una consulta contextual sobre el objeto.

En el ejemplo que publicó la compañía, alguien le pide información a Gemini (la inteligencia artificial de Google, gran protagonista de este evento, y que está integrando en todos sus servicios) sobre cómo se usa un tocadiscos, sin nombrarlo como tal, pero recibiendo una respuesta generada -por Google- específicamente para esa consulta.

Esto es, ya no es necesario tener claro qué estamos buscando (en lo práctico, al menos; la parte metafísica queda para otra nota): alcanza con mostrárselo a Google para que nos diga qué es y cómo funciona (sin ser infalible, por supuesto: dependerá de la claridad con la que podamos mostrarle a Gemini el elemento de nuestra consulta, de su popularidad, de si es de manufactura estándar o único, etcétera). ¿Es la salvación del ferretero, que ya no tendrá que recibir consultas sobre “pitutos” y “el coso que hace así”? Quizás.

Resultados hechos a medida

Como sea, esa consulta no pasó por la web tradicional: fue identificada por la IA, y resuelta en una página generada ex profeso por la compañía para esa ocasión. La búsqueda visual en video, que será parte de Google Lens, estará disponible más adelante. También podría haber funcionado como una respuesta verbal, como parte de un diálogo entre nosotros y Gemini, que reemplaza al Asistente de Google tradicional que tenemos en el teléfono (y que ya funciona en la Argentina).

El martes Google habilitó también, primero para Estados Unidos y más adelante para el resto del mundo, una herramienta que anunció hace un año en la Google I/O de 2023, que estuvo en beta durante todo este año, y que ahora está disponible oficialmente (y que se puede probar en la Argentina). ¿De qué se trata? De hacer una consulta en Google y no recibir una lista de sitios que tienen esas mismas palabras o frases, como en los últimos 25 años, sino un texto generado por inteligencia artificial que responde exactamente eso que buscamos. Una respuesta a medida.

Google afirma que esa herramienta, llamada AI Overview (o Resúmenes creados por IA, en español), no aparecerá siempre -a veces buscamos un dato concreto, o llegar a un sitio específico, y no nos sirve más información-, pero sí permitirá responder a consultas, incluso algunas que son varias preguntas encadenadas, y que en la versión tradicional de la web hubieran requerido varios pasos. Aquí, cortesía de Gemini (el ChatGPT de Google) la compañía generará una respuesta elaborada, con un texto inédito -es decir, creado para responder a esa consulta específica- y ajustado a nuestros intereses, historial, etcétera. Incluso se podrán elegir diversos niveles de complejidad. Lo dice la compañía en su video promocional: “dejá que Google googlee por vos”.

Cómo funciona AI Overview, la búsqueda en Google asistida por inteligencia artificial

El sistema funciona muy bien, pero puede terminar siendo ruinoso para buena parte de la web: acrecienta lo que se conoce como “búsquedas con cero clic”, es decir, consultas a Google que se resuelven en el mismo sitio y no llevan a otra página. No son nuevas: hace muchos años que Google brinda muchísima información en su propio sitio: el reporte meteorológico, resultados deportivos, datos resumidos sobre un político, la cartelera del cine, una calculadora y mil más; en inglés se los conoce como “snippets”, o recortes.

Pero hasta ahora lo hacía solo con contenido estructurado; cosas que ya fueron organizadas en un sitio ajeno, y que Google reproduce (citando la fuente) en el propio. Ahora lo hará con casi cualquier consulta, sin importar su complejidad o singularidad. Es cierto que en los resultados asistidos por inteligencia artificial la compañía pone los links a los sitios que sirvieron de fuente de información para que compilara la respuesta; no es menos cierto que la mayoría de la gente no visitará a esos sitios, que hasta ahora vivían, en buena medida, de las visitas que les derivaba Google por ofrecer respuestas a las consultas de los usuarios. Google, es justo decirlo, permitirá también hacer búsquedas al estilo tradicional, con una lista de links como resultado.

Hace un año, cuando anunciaron la herramienta que genera respuestas a medida, en Google decían que en sus pruebas no habían notado una disminución en el tráfico saliente; veremos qué sucede ahora, cuando se masifique su uso. Por lo pronto, no le queda otra alternativa que moverse en esta dirección: desde su nacimiento, ChatGPT viene sumando puntos para ser una alternativa a Google a la hora de resolver, con inteligencia artificial, algunas consultas generales; de hecho, el lunes OpenAI presentó GPT-4o, su nuevo motor de inteligencia artificial, pero el rumor anterior al que buena parte de la comunidad le daba mucha credibilidad era que ChatGPT sumaría un buscador, para competir con Google en el suministro de información no atada a la actualidad.

La otra duda sobre esta nueva forma de buscar que está ofreciendo Google tiene que ver con lo que usualmente se llama alucinación, y que son errores que la IA inserta en la devolución de una consulta, pero que están expresados con tal seguridad que pueden pasar desapercibidos por alguien que no conozca de antemano parte de la respuesta. Esto es: Google ya no estará citando una fuente externa (y delegando en ella la responsabilidad, llegado el caso, si el contenido es incorrecto), sino generando una respuesta propia, inspirada -o educada- por terceros.

Si el uso inocente que muchos escolares -y no tan jóvenes, incluso cuando deberían estar atentos a estas cosas- le dan a las respuestas de ChatGPT para resolver sus tareas es indicativo de algo, las de Google Gemini serán tomadas al pie de la letra, sin importar los errores que contengan. A la vez, Google podría tener la oportunidad de separarse de ChatGPT mostrando cómo sus respuestas son más certeras, e incluyen menos errores (no parece que sea el caso, por ahora). Como sea, la intención es que se resuelva sin navegar por la web: todo podría quedar resuelto en google.com.

1

1Xiaomi incorpora robots humanoides a su fábrica de autos eléctricos en Pekín

2

2Científicos argentinos crearon Retinar: usan IA para la detección precoz de enfermedades de la vista

3

3Gemini se integra aún más con Google Drive, Docs, Hojas de cálculo y Presentaciones

4

4¿Qué profesiones van a desaparecer con la IA? La respuesta de uno de los expertos argentinos más escuchados