El cerebro electrónico cumple medio siglo pasado mañana

Lanzado por Intel el 15 de noviembre de 1971, es el motor de la revolución digital; ¿pero cómo fue verlo nacer en primera persona?

6 minutos de lectura'

6 minutos de lectura'

Ha sido un raro privilegio, y fue mayormente suerte. Nacer en el momento justo, en la familia adecuada. El hecho es que asistí en primera persona, como testigo, sin que me lo contaran, al nacimiento de uno de esos inventos que cambian el mundo para siempre, el cerebro electrónico.

Pasado mañana se cumplirá medio siglo del primer microprocesador comercialmente disponible, el Intel 4004, lanzado el 15 de noviembre de 1971. Comercialmente disponible significa que cualquier fabricante de calculadoras podía ir y comprar uno de estos dispositivos y usarlo en sus máquinas.

Porque sí, todo esto de las computadoras económicas, los celulares y una internet accesible arrancó con una calculadora. La firma japonesa Busicom le había pedido a Intel el diseño para una nueva calculadora de escritorio. A la firma estadounidense se le ocurrió una idea brillante y aquí estamos, medio siglo después y con un mundo que no tiene nada que ver con el de entonces en casi ningún sentido que quieran plantearse. Desde cómo buscamos pareja o compramos pasajes hasta la forma en la que el presidente de una potencia nuclear informa al mundo una decisión, las computadoras económicas, los smartphones y una vasta red planetaria accesible a casi todos lo cambiaron todo. Estos inventos son el derivado de otro: el microprocesador, cerebro electrónico o CPU, por sus siglas en inglés.

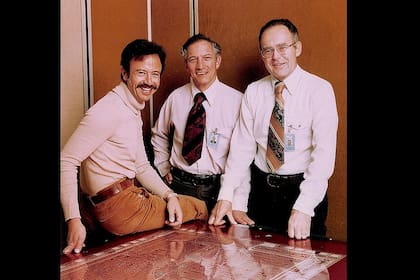

La historia es bien conocida, pero en esencia ocurrió así: a un ingeniero de Intel llamado Marcian Hoff se le ocurrió integrar en un solo chip todos los circuitos que hacían a una calculadora de escritorio. Esto reduciría el tamaño del equipo y aceleraría la comunicación entre los diversos componentes. Para poner en práctica esa idea emplearon una tecnología que el ingeniero Federico Fagin había desarrollado en la compañía Fairchild, de donde provenían los fundadores de Intel, Robert Noyce (que había cofundado Fairchild e inventado el circuito integrado) y Gordon Moore (el autor de la Ley de Moore). Como suele ocurrir, lo del CPU fue algo más bien insignificante al principio, porque la compañía tenía centrado su negocio en los chips de memoria.

En todo caso, lograron establecer un método práctico, escalable y confiable para fabricar un un chip que cabía en la palma de la mano, pero que era una calculadora completa. Parece normal. Pero hace medio siglo no era ni remotamente normal.

Aparte de la caja registradora mecánica –que todos conocemos, porque las vimos funcionando en el mundo real o en el cine–, cuando era chico pude ver algunas de las primeras calculadoras electrónicas que se fabricaron antes del nacimiento del CPU. Esas máquinas podían pesar más de 2 kilos (algunas, anteriores, llegaban a los 8) y solo eran capaces de realizar las cuatro operaciones básicas: sumar, restar, multiplicar y dividir. O sea, sí, pesaban lo mismo que una notebook, pero solo servían para la aritmética más básica. Esto explica un poco el porqué del prejuicio que estos armatostes despertaron al principio. No había modo de ver (casi nunca hay) la proyección que esas calculadoras antediluvianas tenían en el futuro. De momento, no eran mucho más prácticas que el lápiz y el papel, con el agravante de que te ibas olvidando de las tablas y de cómo dividir con coma.

Sin embargo, se estaba produciendo una evolución lenta pero constante que conocemos como miniaturización, y cuyos resultados, aunque hoy están a la vista de todos, escapan por completo a nuestra comprensión. Por primera vez en la historia humana, los componentes de nuestras herramientas solo pueden verse usando un microscopio. Un microscopio electrónico. Uno óptico convencional no sirve.

La progresión, muy grosso modo, fue así, en el taller de mi padre, en el primer piso del caserón de Barracas. Primero estaba todo lleno de válvulas de vacío, grandes como lamparitas, y en algunos casos mucho más, que luego fueron reemplazadas por los transistores, soldados a plaquetas electrónicas. De pronto, las plaquetas electrónicas empezaron a tener, además de transistores, resistencias y condensadores, unos componentes nuevos y raros. Se trataba de los chips, como arañas negras con muchas patitas.

Sin que todavía lo supiera, adentro de cada chip se alojaba el equivalente de una plaqueta. Estaba viendo la miniaturización en tiempo real, en el taller de mi padre. De las válvulas a los transistores, de los transistores a los circuitos integrados, y entonces llegó el paso clave: el cerebro electrónico. Todos los componentes que constituían el motor de una calculadora y, más tarde, computadoras y celulares, habían sido alojados dentro de un solo chip. A medida que los métodos de fabricación mejoraron, y gracias a que todos los componentes se encontraban en una misma pastilla de silicio, fueron achicándose y haciéndose más veloces.

Así, de máquinas de varias toneladas pasamos a celulares que pesan entre 140 y 180 gramos y sin embargo son decenas de miles de veces más potentes que esas computadoras gigantescas.

Un buen año

El cerebro electrónico, que está cumpliendo medio siglo (nació el mismo año que el email), es una implementación de nuestra capacidad de reducir el tamaño de los componentes hasta límites que desafían la comprensión cotidiana de las cosas. Los transistores que en mi infancia tenían el tamaño de una moneda, y que poco antes eran válvulas de vacío grandes como focos de luz, hoy son cientos de veces más pequeños que un glóbulo rojo. Pero la miniaturización ha sido tan brutal que estas tecnologías están llegando a un límite, más allá del cual los átomos se desvanecen en subpartículas. Como consecuencia, la industria está pensando, por un lado, en cómo estirar la idea del CPU tradicional, fabricado de silicio y cobre, y, por otro, en nuevas formas de cómputo. No sabemos con exactitud cuáles serán esas nuevas modalidades. La que más suena hoy es la computación cuántica, que usa alguna de las propiedades cuánticas para representar valores, de un modo análogo a como usamos los semiconductores para representar unos y ceros. Pero también se están investigando cosas mucho más exóticas, como la computación mediante bacterias o ADN.

En mi experiencia, que fue muy temprana y por lo tanto marcó mucho mi visión del mundo (o sea, bien podría estar en este punto siendo prejuicioso), es muy difícil anticipar cómo será el próximo medio siglo de los cerebros electrónicos. Tenemos silicio para un buen rato todavía, de eso estoy casi seguro, aunque es bastante difícil determinar la escala de tiempo que contiene la frase “un buen rato”. Pero no sabemos qué viene después. Puedo atestiguar, en cambio, que el primer medio siglo fue sorprendente, emocionante y que todos los veteranos lo miramos con un poco de sana nostalgia. Y eso que fue diseñado mayormente con lápiz y papel.

1

1Xiaomi incorpora robots humanoides a su fábrica de autos eléctricos en Pekín

2

2Científicos argentinos crearon Retinar: usan IA para la detección precoz de enfermedades de la vista

3

3Gemini se integra aún más con Google Drive, Docs, Hojas de cálculo y Presentaciones

4

4¿Qué profesiones van a desaparecer con la IA? La respuesta de uno de los expertos argentinos más escuchados