Cuidado: si el CEO te llama por WhatsApp, puede ser una estafa, como comprobó este empleado de LastPass

Un empleado de LastPass, la compañía que hace un gestor de contraseñas, denunció que fue víctima de un intento de estafa por alguien que usó un deepfake de audio para hacerse pasar por el CEO de la empresa

- 3 minutos de lectura'

Un actor malicioso intentó engañar a un empleado de LastPass mediante la técnica de deepfake, enviándole al menos un mensaje de voz a través de la plataforma de comunicación WhatsApp y en los que se hacía pasar por el director ejecutivo de la compañía.

Los deepfakes de voz se generan a través de herramientas de Inteligencia Artificial (IA) que crean copias sintéticas de la voz de otra persona. Esto es posible porque esta tecnología utiliza técnicas de aprendizaje profundo para replicar el habla con un audio realista y convincente, debido a sus similitudes con la voz humana.

LastPass ha informado de que recientemente uno de sus empleados, potencial víctima de una estafa de este tipo, supo reconocer el engaño, después de que el CEO de la compañía, Karim Toubba, presuntamente se pusiera en contacto con él de manera urgente.

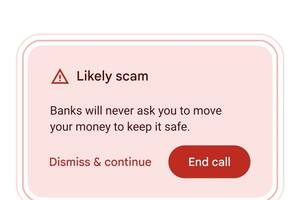

La compañía ha dicho que este tipo de intento de estafa con ‘deepfake’, que no ha tenido ningún impacto para la empresa, se realizó fuera de los canales normales de comunicación corporativos. En este caso, a través de WhatsApp, aplicación a la que realizaron una serie de llamadas y enviaron mensajes de texto y al menos una nota de voz de esta persona.

Esto hizo que el empleado sospechase de la acción del presunto director ejecutivo de la firma, motivo por el que ignoró los mensajes con los que se quiso captar su atención y reportó el incidente al departamento correspondiente de LastPass.

La firma ha recordado que los deepfakes cada vez son más frecuentes y no solo en el ámbito de los actores de amenazas de Estado-nación sofisticados, sino que se han democratizado en los últimos meses. Por ese motivo, ya trabaja con sus socios de inteligencia y otras empresas de ciberseguridad para darles a conocer este formato y ayudar a las organizaciones “a ir un paso por delante de los estafadores”.

Fáciles de crear

La clonación de voces emplea la voz real de otro individuo para producir una interpretación realista de la original, de modo que para crear un deepfake, solo es necesario recopilar una o varias muestras de la voz humana que se quiera copiar, ya sea a través del audio de un vídeo o mediante una grabación física de alguien hablando.

Una vez recogida la muestra, se analiza con un software para identificar las características de la voz y se utiliza para entrenar un modelo de aprendizaje automático (‘machine learning’), con un algoritmo que sea capaz de imitar la voz original.

Además de que los deepfakes son relativamente fáciles de crear, cada vez tienen mayor calidad y actualmente hay numerosos sitios y aplicaciones disponibles para poder hacerlo, por lo que se ha convertido en una técnica habitual entre los ciberdelincuentes, tanto a nivel público -en redes sociales y foros- como a nivel privado, esto es, en empresas.

En 2019, una empresa con sede en Reino Unido fue víctima supuestamente de un audio deepfake en el que se convenció a un empleado para que transfiriera dinero a un estafador que utilizó un software de IA generativa para hacerse pasar por el directivo de la empresa.

Más recientemente, en febrero de este año, el empleado de una multinacional británica con sede en Hong Kong fue víctima de un deepfake de vídeo y voz, con el que los estafadores lograron robar cerca de 200 millones de dólares de Hong Kong (unos 24 millones de euros).

Esto fue posible porque los cibercriminales emplearon la imagen del director de finanzas y de otros ejecutivos de la filial para ponerse en contacto con la víctima y ordenarle que hiciese una transferencia.