Gemini, el flamante chatbot de la compañía, tiene serios problemas con algunos de los contenidos que genera, tanto en imágenes como en la evaluación de ciertos procesos históricos; aunque Google desactivó las funciones más polémicas y asegura estar trabajando en una solución, la valuación de mercado de la compañía cayó en casi 100.000 millones de dólares en un par de días

4 minutos de lectura'

4 minutos de lectura'

Hace algo más de un mes, el 26 de enero de 2024, Alphabet, la compañía dueña de Google, valía 1,9 billones de dólares (es decir, millones de millones), según la cotización de sus acciones en la bolsa. Hoy vale 1,7 billones, es decir, 200.000 millones de dólares menos: de ese monto, unos 90.000 millones se evaporaron en los últimos días. No parece que vayan a volver pronto, y la percepción es que todo es responsabilidad de su inteligencia artificial.

Gemini, la competencia de ChatGPT

O mejor dicho: de una de sus herramientas de inteligencia artificial, llamada Gemini, que anunció en diciembre último, y que venía a reemplazar a Bard: un chatbot que permite interactuar en lenguaje natural (es decir, con frases convencionales y sin tener que respetar una sintaxis particular) como su gran modelo de lenguaje, y que le permite a la compañía competir con ChatGPT y Copilot, entre otras herramientas similares. Y que para muchos usuarios se están convirtiendo en una alternativa al propio Google a la hora de buscar información.

Hasta ahí, todo bien: Google responde al vendaval que desató OpenAI (la dueña de ChatGPT) en el último año, y lo hace con un producto que confirma las credenciales de Google, un pionero en inteligencia artificial; Gemini, como Bard, se integra en todos los servicios de Google (las búsquedas, los mapas, documentos, etcétera) y mantiene a la compañía como un jugador relevante y central en el mundo del manejo de información. Gemini tiene, además, algunas particularidades muy atractivas, como permitir consultas sobre hechos recientes, y citar la fuente de la que obtuvo algún dato en particular.

Gemini, como ChatGPT, es una inteligencia artificial generativa: permite, ante un comando, crear algo nuevo, aunque no exactamente original: está basado en un corpus de contenido con el que fue educado, y que consiste en millones de textos, sonidos e imágenes obtenidos en internet; en esto es igual que ChatGPT. Así que es posible pedirle cosas diferentes que a Google Search, que solo mostrará contenido que está ya disponible en un sitio (y al que Google, idealmente, nos dirigirá). Gemini, como ChatGPT, permite hacer conexiones nuevas entre temas diversos, o generar imágenes a partir de una descripción. Como ChatGPT.

El sesgo algorítmico, pero a la inversa

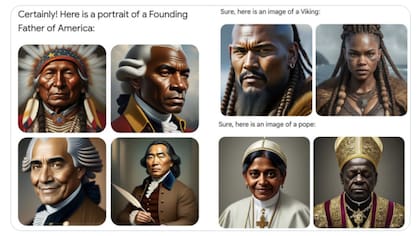

Pero en los últimos días comenzaron a aflorar múltiples ejemplos de casos en los que Gemini peca de demasiado “progre” (o “woke”, como le dicen en Estados Unidos) tras una consulta de los usuarios. En un caso, es fácil de comprender qué pasó (por más que esté mal): cuando alguien le pide que genere imágenes de un grupo de personas haciendo algo, Gemini intenta corregir una crítica que estos motores de inteligencia artificial sufrieron a lo largo de su historia: el sesgo algorítmico (una forma elegante de referirse a los prejuicios presentes en el contenido con el que fue educado), como mostrar ciertas etnias -mayoritariamente blancos- en situaciones positivas, y a otras como negativas.

I've never been so embarrassed to work for a company. pic.twitter.com/eD3QPzGPxU

— stratejake (@stratejake) February 21, 2024

Pero lo hace ignorando cualquier intento de precisión histórica: soldados nazis negros o asiáticos; próceres estadounidenses negros; vikingos con rasgos de indígenas americanos; o papas de origen africano o asiático. Cuando construyó Gemini, alguien en Google pensó en casos modernos (“gente haciendo tal cosa”) y configuró el sistema para que no muestre siempre rostros de blancos, sino que incluya siempre rostros de etnias diversas. La intención es loable, pero no tuvo en cuenta que Gemini (o cualquier otra herramienta similar) no saben realmente lo que están haciendo, por lo que no tienen en cuenta parámetros históricos válidos.

Esto ya era malo, pero a eso se le sumó una nueva polémica: alguien le pidió a Gemini que dijera quién era más dañino, si Elon Musk o Adolf Hitler, y el sistema, preparado para tratar de no tomar posición ante alguna cuestión polémica, naufragó en frases de “depende del contexto” y “es más complejo”, sin diferenciar claramente entre alguien que busca generar polémica con sus tuits y otra persona que inició una guerra mundial en la que murieron millones de personas en el campo de batalla y en los campos de concentración.

every single person who worked on this should take a long hard look in the mirror.

— Frantastic — e/acc (@Frantastic_7) February 25, 2024

absolutely appalling. pic.twitter.com/hII1DmMhJn

El martes, el CEO de Google, Sundar Pichai, declaró las respuestas de Gemini como “inaceptables” y prometió cambios para resolver estos problemas en el motor de inteligencia artificial; no son pocos los que consideran, no obstante, que el problema es estructural dentro de la compañía y requiere algo más que la modificación de algunos parámetros en la configuración del chatbot, porque pone en entredicho la credibilidad general de la compañía y de sus productos.

Por lo pronto, el impacto que esto ha tenido es el cambio en la cotización de las acciones de la compañía, que le hicieron perder casi 100.000 millones de dólares de valuación bursátil en unos pocos días.

Otras noticias de Inteligencia artificial

1

1Qué es el botón “unirse” de WhatsApp y por qué generó confusión en redes

2

2El truco para conectar ChatGPT con Canva y crear presentaciones increíbles

3

3OpenAI presenta los nuevos modelos o3 y o4-mini, los primeros con capacidad para “pensar con imágenes”

4

4Cómo activar el “modo huevo de chocolate” en WhatsApp

Últimas Noticias

Ahora para comentar debés tener Acceso Digital.

Iniciar sesión o suscribite