Un equipo de investigadores ha creado una herramienta que modifica las fotografías para evitar que sean procesadas por sistemas de aprendizaje automático

- 5 minutos de lectura'

En el siglo XXI, el anonimato no es cosa fácil. No con nuestras vidas retratadas en nuestras redes sociales, y no con empresas como la estadounidense Clearview recopilando miles de millones de fotos de ciudadanos de todo el mundo para desarrollar y ofrecer servicios de reconocimiento facial. “Lo que hacen empresas como esta es analizar toneladas de imágenes de las redes sociales y crear una enorme base de datos con muchas fotos para cada persona. La de tu perfil de LinkedIn, la de Facebook…”, explica Micah Goldblum, investigador especializado en aprendizaje automático de la Universidad de Maryland. Para evitar que nuestras fotos acaben en esas populosas galerías, tenemos dos opciones: no subirlas a Internet o dejarlas irreconocibles.

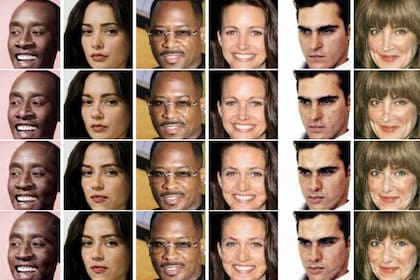

LowKey apuesta por la segunda opción. Esta herramienta modifica las imágenes con el doble objetivo de que las personas retratadas en ellas sigan siendo identificables para el ojo humano, pero resulten indescifrables para los sistemas de reconocimiento facial. Una vez procesadas en esta plataforma, la precisión con que se identifican estas imágenes cae por debajo del 1%. La aplicación es el resultado un equipo de investigadores del que forman parte Golblum junto con Valeria Cherepanova, Tom Goldstein, Shiyuan Duan, John Dickerson, Gavin Taylor y Harrison Foley.

La tecnología de LowKey emplea los ataques llamados adversariales, que se caracterizan por buscar la manera de engañar a los sistemas de aprendizaje automático. En investigación, estos sistemas se suelen emplear para establecer una suerte de juego del gato y el ratón en el que los avances de un modelo impulsan las mejoras del otro, pero resultan de escasa utilidad práctica para un ciudadano cualquiera. “Mucho de lo que se ha hecho en este campo se centra en problemas que solo son interesantes para los investigadores”, señala Goldblum. En contraste, LowKey ya está al alcance de cualquiera en una web que permite subir las imágenes originales, ajustar la intensidad del ataque y descargar su versión envenenada.

¿Cómo lo hace? La herramienta retoca el aspecto de las fotografías desde el punto de vista de la máquina. “Estas redes neuronales toman tu cara y la transforman en una serie de números que describen sus propiedades”, precisa Goldblum. Esa traducción del rostro a números es ilegible para nosotros: no representa el ancho de la nariz ni está asociada al color del pelo. Es una representación del modo en que piensa el ordenador, de manera que para engañar al sistema no necesitamos maquillajes ni pelucas, sino introducir las modificaciones que den como resultado una serie numérica distinta.

“Siempre es posible modificar una imagen con éxito”, subraya Goldstein. El verdadero reto de LowKey es que, ante el ojo humano, la imagen modificada siga teniendo un parecido aceptable con la original. “En algunos casos, conseguimos el objetivo con perturbaciones muy pequeñas, pero en otros los cambios son muy grandes”, admite el experto.

Cajas negras

Los entresijos de sistemas de reconocimiento facial como Amazon Rekognition o Microsoft Azure Face Recognition API, con los que se ha puesto a prueba LowKey, no están disponibles para el gran público, puesto que son propiedad privada de las empresas que los han desarrollado. Esto ha obligado a los investigadores a desarrollar su tecnología adversarial a tientas, basando sus ataques en la información disponible sobre las últimas herramientas aplicadas a la identificación de individuos. También es la razón de la variabilidad de los resultados que se obtienen, pero el equipo continúa trabajando para mejorar este apartado. “Por ahora, LowKey funciona con fotos individuales y consigue modificaciones menos visibles con imágenes pequeñas, de baja resolución”, precisa Valeria Cherepanova.

¿Podemos esperar que su sistema siga funcionando conforme estas empresas modifican sus sistemas de reconocimiento facial? Según explica Goldblum, una feliz consecuencia de haber diseñado LowKey a ciegas es que sus efectos son bastante generales: “Al tiempo que se han vuelto más complejas, las redes neuronales también se han vuelto más fáciles de engañar. Si no están tratando de defenderse específicamente de LowKey, sino de lograr sistemas de reconocimiento más y más avanzados, no veo ninguna razón para pensar que se van a volver menos vulnerables al engaño”.

Además de poner al alcance del público una herramienta de uso sencillo para proteger sus fotos, LowKey persigue el objetivo de crear conciencia de la vulnerabilidad de los contenidos que se suben a la red. Si utilizamos esta herramienta, emborronamos los contenidos nuevos, pero no podemos rescatar la información que ya ha podido ser recabada de imágenes anteriores. “Mucha gente no tiene buenas prácticas en lo que respecta a redes sociales y privacidad. Sencillamente suben montones de imágenes de sí mismos en diferentes lugares. Y, como resultado, ofrecen un montón de información que puede usarse para identificarles”, razona Goldstein. En este sentido, una aproximación más segura sería limitar al máximo el número de fotos que empleamos: si tenemos tres cuentas en distintas plataformas utilizar la misma en las tres. “Lo mejor que podemos sacar de LowKey es un mejor entendimiento del problema y del modo en que se usa la información personal”.

EL PAIS

EL PAIS