Peligrosos usos de la inteligencia artificial

Recientemente tomó estado público que un joven menor de edad (15 años), oriundo de la localidad de San Andrés, partido de General San Martín, provincia de Buenos Aires, habría manipulado imágenes de sus compañeras de colegio mediante la utilización de sistemas de inteligencia artificial (IA), generando desnudos (nudes) con la imagen de las chicas, para comercializarlas a través de la plataforma Discord (programa de comunicación gratuito que permite compartir chats de texto, voz y video mediante la generación de grupos privados).

En otras palabras, este joven habría tomado fotos de sus compañeras de clase y las habría “desnudado” utilizando IA, para vender dichas imágenes en el mercado a través de la plataforma mencionada.

La tecnología que se habría utilizado es la denominada deepfake que permite editar videos (voz incluída) o imágenes falsas de personas que aparentemente son reales, pero que no lo son, utilizando para ello fotografías que usualmente son tomadas de las redes sociales de las víctimas. Eso incluye la posibilidad de crear supuestas personas actuando de una manera que no es real, simulándose de ese modo acciones que nunca se ejecutaron.

A este tipo de sistemas de IA se sumó la aplicación “Sora” (de OpenIA) que permite al usuario la creación de un video a partir de instrucciones de texto, esto es, la generación de video-contenido a partir de frases.

Situaciones como la ocurrida con las alumnas del colegio de la localidad de San Andrés se multiplican, como el caso testigo de Almendralejo (España) cuando, a fines de 2023, distintas adolescentes fueron víctimas de hechos similares al ser tomadas sus imágenes de Instagram para fabricar nudes eróticos falsos distribuidos en distintos sitios webs por un compañero de aula.

Estrellas de la canción como Taylor Swift y de Hollywood como Scarlett Johansson, como asimismo el propio papa Francisco y Donald Trump han sido víctimas de esta tecnología, e inclusive han promovido acciones legales contra sus desarrolladores ya que, en muchos casos, sus fotografías y/o videos han sido utilizados para desinformar e influenciar a la población en determinado sentido; principalmente en el voto.

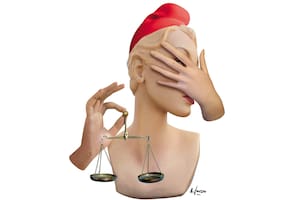

Ahora bien, frente al hecho puntual ocurrido en San Andrés y demás antecedentes mencionados, las preguntas que se imponen son las siguientes: ¿qué responsabilidad legal cabe al autor de este tipo de hechos?, ¿qué respuestas legislativas se esperan al respecto?

En materia de responsabilidad civil, el derecho personalísimo a la imagen de las chicas involucradas en este despropósito encuentra protección legal en el artículo 31 de la ley 11.723 cuando refiere, como principio general, que “…el retrato fotográfico de una persona no puede ser puesto en el comercio (utilizado) sin el consentimiento expreso….”.

El artículo 53 del Código Civil y Comercial de la Nación refuerza la protección de la ley mencionada incluyendo asimismo a la voz de una persona, que tampoco puede ser reproducida, bajo ninguna forma, sin su expresa autorización. Eso adquiere máxima relevancia en los casos de la grabación de conversaciones en ámbitos públicos y privados sin autorización de alguno de los participantes, y los supuestos de deepfake.

Al respecto, la Corte Suprema de Justicia de la Nación sostuvo en reiteradas oportunidades que el legislador ha prohibido, como regla, la reproducción de la imagen (y la voz) en resguardo del correlativo derecho a ella, restricción que sólo cede si se dan específicas circunstancias que tengan en mira un interés general que aconseje hacerlas prevalecer por sobre aquel derecho.

El amparo legal se extiende a cualesquier técnica de reproducción de los rasgos físicos de una persona, con prescindencia del procedimiento empleado y del soporte material en el cual se fija la imagen.

Dicho en criollo, nadie puede utilizar ni comercializar la imagen ni la voz de otra persona sin su consentimiento bajo pena de responder por los daños y perjuicios causados. Si el autor de los hechos es menor de edad puede surgir la responsabilidad de los padres, sobre los que recae la obligación de custodia, guarda y debida vigilancia.

En cuanto a las respuestas legislativas para penalizar este tipo de acciones, sin perjuicio de que estos hechos pueden calificarse como “violencia de género digital”, se han presentado en el Congreso Nacional algunos proyectos de ley que persiguen encuadres (tipos) penales especiales.

Por ejemplo, los proyectos de ley presentados por los diputados Juan Fernando Brugge y Gerardo Milman, con similares fundamentos y diferente extensión normativa, proponen modificar el Código Penal de la Nación y establecer fuertes penas de prisión para todo aquel que incurra en este tipo de acciones, ya sea mediante la producción, financiación y/o comercialización de imágenes elaboradas y/o modificadas por sistemas deepfake.

Lógicamente, siempre es mejor prevenir que curar, por lo cual resulta aconsejable evitar este tipo de hechos con un adecuado marco de concientización en el nivel familiar y educativo, mediante su tratamiento en el aula, incluyendo una modificación en la ley de educación superior que establezca, como materia obligatoria, el tratamiento de estas cuestiones y/o cualquiera vinculada al uso responsable de herramientas informáticas y sistemas de IA.

La IA asegura grandes oportunidades y beneficios para la humanidad, aunque también facilita herramientas que permiten confundir la identidad de las cosas y de las personas, como asimismo la desinformación y la mentira.

Dependerá de los Estados establecer normas de juego claras que permitan identificar este tipo de situaciones y sancionarlas razonablemente, sin afectar el desarrollo de una industria que ha prometido actuar con ética proactiva, sujeta a verificación en el tiempo. Hasta que eso suceda, navegaremos aguas peligrosas.

Abogado y académico en Derecho Digital y Data Privacy. Profesor de la Facultad de Derecho de la Universidad de Buenos Aires y de la Universidad Austral