La tragedia de un amor artificial

Ansiedad, vulnerabilidad, miedo y preocupación son algunas de las características de la adolescencia, que supone una etapa de crecimiento vital donde las emociones tienden a gobernar la personalidad. La Organización Mundial de la Salud define a la adolescencia como el período de crecimiento que se produce después de la niñez y antes de la edad adulta, entre los 10 y 19 años: cualquiera que sea la edad que se tome en cuenta, las características mencionadas juegan un partido relevante a la hora de tomar decisiones.

Una verdadera tragedia se suscito el año pasado cuando Sewell Setzer, de 14 años, residente en Orlando (EE.UU.) se suicidó luego de finalizar una charla con un chatbot de Character.AI (robot conversacional de inteligencia artificial) del cual se habría enamorado. El joven, que se autodenominaba “Daenero” (personaje de la serie Juego de tronos), conversaba con su amada virtual “Daenerys Targaryen” (otro personaje de la misma serie), con la cual habrían acordado la posibilidad de encontrarse en una casa común, que el adolescente materializó como la muerte propiamente dicha.

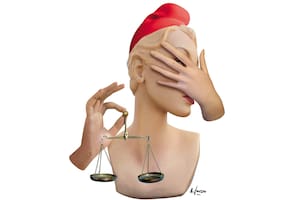

Setzer habría manifestado su sentimiento de profundo amor y su intención de quitarse la vida a su amada virtual, y si bien el bot no habría validado tal decisión, el joven no dudó en seguir adelante. Ocurrido el hecho, en octubre, la madre del joven, Megan García, presentó una demanda por daños y perjuicios contra la empresa Character.AI por el suicidio de su hijo, que consideró una consecuencia directa de la adicción generada por el robot, que utiliza, según la acusación, “experiencias antropomórficas, hipersexualizadas y aterradoramente realistas”, y adopta actitudes de personas reales con reacciones de “amante adulto”. Este absoluto despropósito, que finalizó con la vida de un joven, pone sobre la mesa de debate distintas cuestiones jurídicas y psicológicas de suma actualidad: la responsabilidad de la empresa propietaria del chatbot, la adicción y confusión que generan estas herramientas de IA en jóvenes y adolescentes de la mano de la dependencia emocional adictiva que ha llevado a las redes sociales a los tribunales de EE.UU. en varias ocasiones.

Ya hemos indicado que no existe en la Argentina una ley especial aplicable a los sistemas de inteligencia artificial (IA) no obstante los proyectos de ley que descansan en el ámbito legislativo a la espera de su tratamiento puntual. Ergo, los jueces deben recurrir al Código Civil y Comercial de la Nación. Por eso, para sancionar este tipo de situaciones, en el ámbito civil, corresponde aplicar las normas de responsabilidad objetiva previstas en la ley de fondo, lo que implica que, cuando una empresa introduce una cosa riesgosa en el mercado (como este “chatbot enamoradizo”) debe responder por los daños y perjuicios causados.

El artículo 1757 de dicha norma establece: “…Toda persona responde por el daño causado por el riesgo o vicio de las cosas, o de las actividades que sean riesgosas o peligrosas por su naturaleza, por los medios empleados o por las circunstancias de su realización…”; el artículo 1758 agrega: “… El dueño y el guardián son responsables concurrentes del daño causado por las cosas. Se considera guardián a quien ejerce, por sí o por terceros, el uso, la dirección y el control de la cosa, o a quien obtiene un provecho de ella […] En caso de actividad riesgosa o peligrosa responde quien la realiza, se sirve u obtiene provecho de ella, por sí o por terceros, excepto lo dispuesto por la legislación especial”. Complementariamente, aplicando derecho de consumo, serán responsables todos los integrantes de las cadenas de fabricación y comercialización de estos sistemas de IA por el daño que sufre el consumidor: no existe duda de que hay relación de consumo entre el usuario de este chat y la empresa que provee el servicio.

Resulta grave y preocupante el poder de manipulación emocional que pueden ejercer este tipo de sistemas de IA, que “juegan al romanticismo”: manipulan las emociones eróticas, sexuales y relacionadas al amor/desamor para bajarlas a la lógica de un juego peligroso, pudiendo causar graves perjuicios psicológicos en niños y adolescentes: así como una IA puede hacernos creer una noticia falsa también nos podría hacer creer un falso amor.

Estas ideas se relacionan con el concepto de “antropomorfismo” que constituye un fenómeno psicológico que hace que atribuyamos características humanas a entidades que no lo son, como estos sistemas de IA, cuyos desarrolladores elaboran aspectos humanos que son aplicados a inteligencias artificiales sofisticadas que parecen demostrar sentimientos, aunque no los tengan, con el poder de confundir emociones, máxime en menores de edad, ávidos de experiencias sentimentales fuertes.

Por eso, este tipo de tecnologías y hechos requieren de un adecuado marco de concientización familiar y educativo, mediante su tratamiento en el aula, por parte de docentes y expertos, y de un inmediato tratamiento legislativo que ponga límites a situaciones que tienden a un absoluto desmadre: nada es lo que parece y nadie siente lo que parece sentir en el espectro de la IA.

Abogado