El universo de la tecnología nos sobrepasa con la fuerza de un tsunami

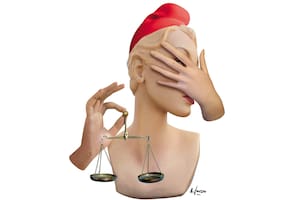

¿Pueden las máquinas sentir emociones y desarrollar sentimientos?, ¿qué rol debería jugar el derecho ante semejante revolución transhumanista? La industria de la IA avanza con escasas reglas que le marquen límites éticos

6 minutos de lectura'

6 minutos de lectura'

Mientras hacemos malabares para pagar la medicina privada y el Gobierno logra exitosamente bajar la inflación a un dígito, el universo de la tecnología nos sobrepasa como un tsunami. Recientemente, en un evento cargado de glamour tecno, la compañía OpenAI presentó el ChatGPT 4-o, una nueva versión gratuita y mejorada de su chatbot de inteligencia artificial generativa (IA) que posibilita, entre otra cosas, procesar audio e imágenes de forma nativa, en tiempo real, permitiendo interacciones relevantes y naturales entre los usuarios y la IA.

La versión GPT 4-o propicia, usando audio y video, una interacción fluida e inmediata (tiempo real) con los usuarios, con la posibilidad de alcanzar “respuesta y expresividad a nivel humano”, tal como refirió Sam Altman, CEO de OpenAI, a tal punto que podría expresar emociones con cierto grado de verosimilitud. La presentación de este nuevo modelo de inteligencia artificial generativa ha puesto sobre la mesa de debate, nuevamente, el hecho de si las máquinas (robots) pueden sentir emociones y desarrollar sentimientos, como asimismo qué rol debería jugar el derecho ante semejante escándalo transhumanista.

El primer interrogante no reconoce respuestas pacíficas. Para algunos periodistas, estudiosos y académicos, es imposible que una IA pueda percibir emociones y desarrollar sentimientos, pero para otros sí podría e, incluso, ya lo está haciendo. Según el Diccionario de la Lengua Española el término “emoción” supone una alteración del ánimo intensa y pasajera, agradable o penosa, que va acompañada de cierta conmoción somática.

Los sentimientos están vinculados a las emociones, ya que se manifiestan como las experiencias subjetivas y conscientes de esas emociones: una persona (sujeto) registra una determinada emoción (miedo, dolor, pasión, atracción, ira) ante una determinada situación, persona, animal, recuerdo o situación de vida y siente (miedo, dolor, etc.).

En consecuencia, así como una persona puede violentarse ante una determinada situación de vida, ¿por qué no podría una máquina, alimentada de inteligencia artificial generativa, programada a medida (por un individuo cargado de ira) violentarse ante la misma persona que la programó? ¿No podrían existir sentimientos (amor) entre un robot programado con algoritmo a medida y un ser humano? ¿Se puede programar un algoritmo que permita sentir a una máquina?

La realidad autoriza sostener que si resulta viable programar una lógica de emociones (como de pensamiento crítico) que estandarice “sentimientos básicos” (universalmente conocidos) las máquinas podrán sentir, y el día que las máquinas sientan estaremos en problemas. Ese día no parece muy lejano. Al respecto, podemos recordar las investigaciones desarrolladas por Blake Lemoine, ingeniero especialista en IA que trabajó para Google y fue despedido por su empleador cuando afirmó que un programa de IA de esa compañía (LaMDA) había cobrado conciencia propia y demostraba sentimientos, con el cual había mantenido conversaciones coherentes sobre sus derechos y lo que quería como persona.

Si bien Lemoine fue desautorizado por Google, que sostuvo, vía comunicado, que sus declaraciones sobre LaMDA no tenían ningún fundamento, también muchos creyeron que Colón estaba loco al sostener que la Tierra era redonda. Lo cierto es que mientras nos enredamos en debates académicos, humanistas y filosóficos, la industria de la IA sigue avanzando, sin descanso, con escasas reglas de juego que marquen la cancha de la ética a un negocio que mueve montañas de dinero, y sin una regulación concreta aplicada a medida: cuando nos demos cuenta de dónde estamos parados, las máquinas van a estar gobernando el planeta.

El único regulador definitivamente interesado, preocupado y ocupado en el tema es la Unión Europea, que ha trabajado en la implementación de la “ley de inteligencia artificial” (artificial intelligent act o AI act) bajo la forma de reglamento de aplicación obligatoria para todos los países que la integran. Esta ley constituye el primer ordenamiento jurídico integral sobre IA en el nivel mundial y persigue regular una IA fiable que garantice que sus sistemas respeten los derechos y la seguridad de los ciudadanos, la evaluación de impacto en materia de derechos humanos y el fomento de la innovación.

Si bien esta ley se encuentra en un proceso final para su entrada en vigor –comprobación lingüística y publicación–, recoge conceptos sustanciales para el desarrollo ético del negocio, clasificando los sistemas de IA según su nivel de riesgo, de acuerdo con el siguiente detalle: los sistemas prohibidos considerados una amenaza para la seguridad y los derechos de las personas, como, por ejemplo, aquellos diseñados para manipular el comportamiento o las decisiones humanas; los sistemas de alto riesgo (por ejemplo, los sistemas de identificación biométrica remota), que estarán sujetos a obligaciones estrictas y a una evaluación obligatoria previa antes de ser introducidos en el mercado; los sistemas de riesgo limitado, vinculados a la transparencia en el uso de la IA, que conllevan la obligación de garantizar un adecuado derecho de información a los usuarios sobre los riesgos de interactuar con una máquina alimentada por IA, y los sistemas de riesgo mínimo, que estarían alcanzados por un código de conducta voluntario.

La Oficina Europea de Inteligencia Artificial, creada en el ámbito de la Comisión Europea, es el organismo encargado de la supervisar el cumplimiento y la aplicación de la ley por los Estados miembros. Como ya lo hemos dicho en reiteradas ocasiones, en la Argentina no contamos con ninguna normativa que regule la inteligencia artificial, sin perjuicio de las denominadas “Recomendaciones para una inteligencia artificial fiable”, aprobadas por la Subsecretaría de Tecnologías de la Información de la Jefatura de Gabinete de Ministros (Disposición 2/2023, de fecha 1º de junio de 2023): una guía conceptual sin rigor científico normativo.

Sin perjuicio de eso, cabe destacar que en abril el Ministerio de Justicia de la Nación lanzó el “Programa nacional integral de inteligencia artificial en la Justicia” (resolución 111/2024 MJ), una iniciativa acertada destinada a modernizar y optimizar los procesos judiciales y los procedimientos administrativos mediante la incorporación de tecnologías innovadoras a través de la implementación de programas que utilizan IA. Siguiendo la línea europea, resulta evidente la necesidad del dictado de una legislación local aplicable a los sistemas de IA (como lo están haciendo otros países de la región tales, como Chile y Brasil), lo que requiere de un análisis serio, completo y coherente, con la convocatoria de expertos y académicos en la materia que ofrezca soluciones que garanticen los derechos individuales de los ciudadanos y su seguridad jurídica.

Todo eso de la mano del desarrollo de espacios educativos de concientización sobre el uso responsable de una tecnología que llegó para quedarse sine die y que nos permitirá, quizás, en poco tiempo, que una máquina sienta emociones humanas, nada más y nada menos.

Abogado y consultor en derecho digital, privacidad y datos personales. Profesor de la Facultad de Derecho de la UBA y de la Universidad Austral