¿Sentido común? ¿Sentido del humor? Los curiosos límites de la inteligencia artificial

Nuevos avances científicos desafían al humanismo con la lógica de los algoritmos

- 5 minutos de lectura'

Sucedió esta semana, durante la inauguración de la Bienal de Venecia, en el pabellón de Uzbekistán, un país ubicado entre China, Pakistán e Irán y próximo a Rusia, que supo formar parte tanto de la Ruta de la Seda medieval que conectaba China con Occidente como, en el siglo pasado, de la Unión de Repúblicas Socialistas Soviéticas. Los artistas uzbekos decidieron reivindicar con oportunismo a un héroe del siglo IX que hoy goza de peculiar fama global: Mohamed al-Khwarizmei o Al-Juarismi, nombre del que deriva el hoy popular término “algoritmo”. Polímata vivió a fines del primer milenio, dominó y explicó los cálculos matemáticos y fue, entre otras virtudes, el introductor de los números arábigos en Europa: ranquea sin dudas entre las tareas científicas de mayor alcance global vigente. “Dixit algorizmi, el jardín del conocimiento” se llama la exhibición que se propone rescatar singulares tradiciones modernistas del islam (Al-Juarismi desarrolló su tarea en Bagdad), desde las tecnologías más actuales y con la mirada de arte contemporáneo.

Los algoritmos en tiempos digitales, de hecho, están en el centro del debate humanista por estos días. Más allá de las discusiones de alcance masivo sobre la intervención de buscadores (Google), asistentes (Siri), redes sociales (Facebook, Instagram) o servicios de mapas o streaming (Netflix) en la selección, recomendación y decisiones cotidianas o preferencias culturales, la solución a problemas mediante operaciones lógicas programables digitalmente cautiva a los más actualizados científicos: habita en la frontera de la Inteligencia Artificial (IA). Los avances y discusiones en ese campo volvieron a estar vigentes por anuncios y novedades que sacuden tanto a inversores financieros de gran escala como a filósofos interesados en la relación del hombre con la tecnología.

¿Pueden las computadoras aprender el sentido común? La pregunta, para nada trivial, titulaba un profundo reporte publicado este mes en la revista The New Yorker. Durante muchos años, los proyectos interesados en la inteligencia artificial se toparon con diferentes obstáculos a la hora de emular (o suplantar) procedimientos mentales humanos. Más allá de asignarle “inteligencia” a las entidades, digamos, robóticas (ya hemos naturalizado llamar “smart” a televisores o teléfonos), el planteo de construir una “inteligencia artificial general” representa una proeza, un límite riesgoso y hasta un dilema ético en la relación humanos-máquinas sobre el que advirtieron desde Isaac Asimov hasta Stephen Hawking.

Tras años áridos de avances significativos, la IA parece volver hoy sobre un asunto crítico: la cantidad de operaciones mentales humanas que dan por sentado un montón de conocimientos de manera... ejem... automática. Eso que llamamos de manera ambigua sentido común. El más claro de ellos: rellenar mentalmente una frase cuando apenas le falta una. Todos los lectores saben que palabra iba allí, pero ¿podrían las máquinas realizar operaciones tan “simples” como esa u otras parecidas?

Los antropólogos volvieron sobre un tema remanido: ¿cómo y cuándo adquirimos esos conocimientos que damos por sentados? Pero para los científicos que forman parte de iniciativas como OpenAI es la verdadera “materia oscura” que aun no pueden resolver. Apenas semanas atrás se revelaron avances en el campo de un modelo de aprendizaje automático llamado GPT-3: más allá de la sigla, el modelo trabaja sobre patrones lingüísticos y empieza a demostrar habilidades para producir escritura bastante similar a la humana. En algunos casos, emula estilos hasta hacer difícil la identificación de su origen robótico. The New York Times trasciende el hito científico y enfoca otro aspecto. En una nota publicada el lunes último, se preguntaba: “La inteligencia artificial ya domina el lenguaje pero, ¿debemos creer lo que nos dice?”. Los expertos ya aventuran cuáles serán las cualidades de la nueva versión, la GPT-4, que se pondría disponible en un par de meses.

Un también reciente paper de Google hacía foco en otro aspecto igual de humano: mostraba que no solo estas “inteligencias” son capaces de mantener conversaciones lógicas, sino también de entender chistes, ¡y hasta explicarlos! Sentido, sentido común y hasta ¿sentido del humor? Puesto en contexto: si los humanos estamos limitando nuestra capacidad de reírnos de los demás a riesgo de ser cancelados o abofeteados como Chris Rock, ¿transferiremos a las máquinas esa cualidad?

Dentro del mismo proyecto de OpenIA se develaron, días atrás, las nuevas habilidades del software Dall-E: con una simple consigna escrita del tipo “simio andando en moto”, el programa logra darnos varias opciones de imágenes creadas para ilustrar el tópico. Aún con límites (conceptos concretos), ya deslumbra al mundo de la imagen y el arte.

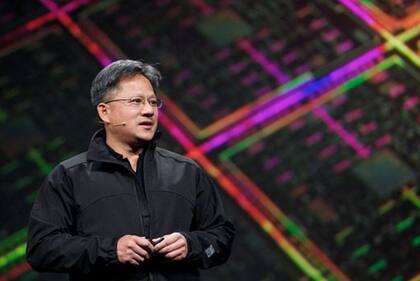

También este mes, Nvidia, empresa líder en este campo (proveedora de Microsoft y Amazon, entre otras), hizo una demostración sorprendente: combina tecnologías que no estaban disponibles una década atrás (machine learning, almacenamiento a escala) que permiten una aceleración de un millón de veces en la capacidad de cómputo para dar lugar a una “inteligencia manufacturada”, la capacidad no ya de imitar sino de crear inteligencia. Su CEO y fundador, Jense Huang, detallaba con ánimo de potenciar su negocio: “Inteligencia es la capacidad de establecer patrones, relaciones, y hacer una predicción o establecer un plan. Es resolver problemas, y hoy podemos lograr que las máquinas creen softwares para resolver problemas”. Una visión audaz de alguien nacido en Taiwan, en 1963, y luego egresado de la Universidad de Stanford que provoca tanto como evoca, igual que en Venecia, al visionario Al-Juarismi.