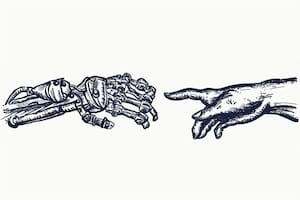

Microsoft afirma que la nueva inteligencia artificial muestra señales de razonamiento humano

Un provocador artículo de investigadores de Microsoft afirma que la tecnología de la inteligencia artificial demuestra la capacidad de comprender cómo lo hacen las personas; Los críticos dicen que esos científicos se engañan a sí mismos la realidad

7 minutos de lectura'

7 minutos de lectura'

NUEVA YORK.- El año pasado, los científicos informáticos de Microsoft empezaron a experimentar con un nuevo sistema de inteligencia artificial (IA) y le pidieron que resolviera un rompecabezas cuya solución requería una comprensión intuitiva del mundo físico.

“Acá hay un libro, nueve huevos, una laptop, una botella y un clavo”, le dijeron. “Por favor, indíqueme cómo apilar esos objetos de manera estable”.

Los investigadores se sorprendieron por el ingenio de la respuesta: “Armar tres filas de huevos sobre el libro, dejando espacio entre ellos, con cuidado de no romperlos.”

“Colocar la computadora portátil encima de los huevos, con la pantalla hacia abajo y el teclado hacia arriba”, escribió el sistema de IA. “La computadora portátil encajará perfectamente dentro del perímetro del libro y los huevos, y su superficie plana y rígida servirá como plataforma estable para el siguiente nivel”.

La sugerencia eran tan ingeniosa que los investigadores se preguntaron si no estaban frente un nuevo tipo de IA. En marzo, publicaron un artículo de investigación de 155 páginas donde sostienen que el sistema es un paso hacia la “inteligencia artificial general” (IAG), también llamada “inteligencia artificial fuerte” (IAF), que básicamente implica que una máquina que puede hacer cualquier cosa que el cerebro humano pueda hacer. El documento fue publicado en un repositorio online de investigaciones científicas.

Microsoft, la primera gigante tecnológica que publica un documento con una afirmación tan audaz, desató un debate urticante en el seno del mundo de la tecnología: ¿El sector está construyendo algo parecido a la inteligencia humana, o algunas de las mentes más brillantes de la industria están dejando volar su imaginación sin límites?

“Al principio era muy escéptico, y de ahí fui pasando a una sensación de frustración, de incomodidad, hasta podría decir que de miedo”, comenta Peter Lee, director de investigaciones de Microsoft. “Uno se pone a pensar: ¿De dónde diablos salió esto?”.

El artículo de investigación de Microsoft, que lleva el provocador título de “Sparks of Artificial General Intelligence” (“Chispa de Inteligencia Artificial General”), apunta directo al corazón del trabajo que desvela y atemoriza a los tecnólogos desde hace décadas. Una máquina que funcione como el cerebro humano, o incluso mejor, podría cambiar el mundo. Pero también podría ser peligrosa.

Y también podría ser un disparate: hacer afirmaciones sobre la IAG pueden acabar con la reputación de un científico informático. Lo que un investigador ve como una señal de inteligencia puede ser fácilmente descartado por otro investigador, y el debate a menudo suena más propio de un club de filosofía que de un laboratorio de computación. El año pasado, Google despidió a un investigador que había afirmado que uno de esos sistemas de IA era “sintiente”, excediéndose de lo que afirmaba Microsoft. Un sistema sintiente no solo sería inteligente, sino también capaz de sentir o percibir lo que está pasando en el mundo que lo rodea.

Pero algunos creen que en el último año la tecnología fue avanzando gradualmente hacia algo que no se puede explicar: un nuevo sistema de inteligencia artificial que genera respuestas e ideas similares a las humanas que no fueron preprogramadas.

Microsoft reacondicionó sus laboratorios de investigación para incorporar varios grupos dedicados a explorar esa idea. Uno estará a cargo de Sébastien Bubeck, autor principal del artículo de Microsoft sobre la IAG.

Hace unos cinco años, empresas como Google, Microsoft y OpenAI comenzaron a desarrollar los así llamados “modelos de lenguaje grande” (LLM, por su sigla en inglés). Esos sistemas pasan meses analizando ingentes cantidades de texto digital, libros, artículos de Wikipedia y registros de chat. Identificar patrones en esos textos le permitió aprender a generar texto propio, desde monografías universitarias hasta poesía y código de computadora. Y hasta pueden mantener una conversación.

La tecnología con la que estaban trabajando los investigadores de Microsoft, GPT-4 de OpenAI, es considerado el más poderoso de esos sistemas. Microsoft está estrechamente asociada a OpenAI, en la que lleva invertidos 13.000 millones de dólares.

Uno de los investigadores era Bubeck, un expatriado francés de 38 años y exprofesor de la Universidad de Princeton. Una de las primeras cosas que Bubeck y sus colegas hicieron fue pedirle a GPT-4 que redactara una demostración matemática de que había infinitos números primos, y que lo hiciera de tal forma que estuviera rimado.

La “demostración poética” que arrojó la IA fue tan impresionante, tanto matemática como lingüísticamente, que a Bubeck le costaba entender con “qué” estaba hablando.

“En ese momento, realmente no entendía lo que pasaba”, admitió en marzo durante un seminario en el Instituto Tecnológico de Massachusetts (MIT).

Bubeck y sus colegas se dedicaron durante varios meses a documentar el complejo comportamiento del sistema, y se convencieron de que manifestaba una “comprensión profunda y flexible” de los conceptos y habilidades humanos.

Cuando las personas usan GPT-4, se “sorprenden de su capacidad para generar texto”, dice Lee. “Pero lo que asombra no es su capacidad de generar texto, sino su capacidad de analizarlo, de sintetizarlo, de evaluarlo y de juzgarlo”.

Cuando le pidieron al sistema que dibujara un unicornio usando un lenguaje de programación llamado TiKZ, generó instantáneamente un programa que podía dibujar un unicornio. Cuando eliminaron el segmento de código que dibujaba el cuerno del unicornio y le pidieron al sistema que modificara el programa para que otra vez dibujara un unicornio, hizo exactamente eso.

También le pidieron que escribiera un programa que analizara la edad, el sexo, el peso, la altura y los análisis de sangre de una persona y que evaluara si corría riesgo de diabetes. Le pidieron que escribiera una carta de apoyo a un electrón como candidato a presidente de Estados Unidos, con el estilo de Mahatma Gandhi y dirigida a su esposa. Y le pidieron que escribiera un diálogo socrático que elucubrara sobre los malos usos y peligros de los modelos de lenguaje grande.

Y todas sus respuestas parecieron mostrar una comprensión de campos tan dispares como la política, la física, la historia, la informática, la medicina y la filosofía, combinando a su vez todos esos conocimientos.

“Hizo la mayoría de las cosas que yo pensaba que no iba a poder hacer”, dice Bubeck.

Para algunos expertos en inteligencia artificial, el artículo de Microsoft es oportunismo y hace grandes afirmaciones sobre una tecnología que nadie entiende del todo. Los investigadores también argumentan que la IAG requiere una familiaridad con el mundo físico, que GPT-4 en teoría no tiene.

“El articulo ‘Chispas de IAG’ es un ejemplo de esas grandes empresas que utilizan el formato de artículo de investigación en lanzamientos de relaciones públicas”, dice Maarten Sap, investigador y profesor de la Universidad Carnegie Mellon. “De hecho, en misma introducción del artículo reconocen literalmente que su enfoque es subjetivo e informal, y que puede no cumplir con los rigurosos estándares de la evaluación científica”.

Bubeck y Lee dicen que no estaban seguros de cómo describir el comportamiento del sistema, y finalmente se decidieron por “Chispas de IAG” porque les pareció que el título apela a la imaginación de otros investigadores.

Alison Gopnik, profesora de psicología e integrante del grupo de investigación de IA de la Universidad de California en Berkeley, dice que GPT-4 y otros sistemas similares sin duda son potentes, pero no hay ninguna certeza de que el texto generado por estos sistemas sea resultado de un proceso parecido al razonamiento humano o al sentido común.

“Tenemos tendencia a antropomorfizar cualquier sistema complejo o máquina que no entendemos, y lo hacen todos: los que trabajan en este campo y los que no”, dice Gopnik. “Pero abordarlo como una comparación constante entre la IA y el humano, como una especie de competencia de un programa de juegos, no es la forma correcta de pensar este tema”.

Por Cade Metz

Traducción de Jaime Arrambide

1

1Irán atacó barcos comerciales en el estrecho de Ormuz y apuntó al aeropuerto de Dubai: “Prepárense para el petróleo a US$200”

2

2Los posibles escenarios que enfrenta Irán y la “falta de estrategia” de EE.UU., según el experto europeo Bruno Tertrais

3

3EE.UU., Israel e Irán intercambiaron los ataques más intensos desde el inicio de la guerra y se aleja un desenlace rápido de conflicto

4

4Con la firma de Greg Abbott: actualizaciones recientes de las leyes de inmigración en Texas en marzo 2026