El socio silencioso que “limpia” el contenido de Facebook por 500 millones de dólares al año

Los trabajadores de la empresa contratista sufren problemas psicológicos por las publicaciones nocivas a las que están expuestos diariamente

- 15 minutos de lectura'

NUEVA YORK.- En 2019, Julie Sweet, la recién designada directora ejecutiva de la consultora global Accenture, sostuvo una reunión con los altos directivos de la compañía. Tenía una pregunta: ¿Accenture debía renunciar a parte del trabajo que estaba haciendo para Facebook, su principal cliente?

Durante años, las tensiones en Accenture habían aumentado debido a una tarea que la empresa realizaba para la red social. En turnos de ocho horas, miles de sus empleados de tiempo completo y contratistas revisaban las publicaciones más nocivas de Facebook, entre ellas imágenes, videos y mensajes sobre suicidios, decapitaciones y actos sexuales, para evitar que se propagaran online.

Algunos de esos trabajadores de Accenture, quienes revisaban cientos de publicaciones de Facebook en sus turnos, comentaron que habían comenzado a experimentar depresión, ansiedad y paranoia. En Estados Unidos, un trabajador se sumó a una demanda colectiva para protestar por las condiciones laborales. La cobertura que se dio en los medios vinculó a Accenture con el trabajo macabro. Por lo tanto, Sweet había ordenado una revisión para debatir sobre los crecientes riesgos éticos, legales y para la reputación de la firma.

En la reunión celebrada en la oficina de Accenture en Washington, según mencionaron personas que estuvieron presentes, Sweet y Ellyn Shook, directora de recursos humanos, revelaron las inquietudes en torno al costo psicológico del trabajo que se hacía para Facebook y el daño para la reputación de la firma. Algunos ejecutivos que supervisaban la cuenta de Facebook arguyeron que los problemas eran manejables. Señalaron que la red social era un cliente demasiado lucrativo como para perderlo.

Facebook y Accenture casi no han hablado sobre su arreglo y ni siquiera han reconocido que trabajan juntos. Sin embargo, su relación secreta se encuentra en el centro de un esfuerzo de la empresa de redes sociales más grande del mundo para distanciarse de la parte más tóxica de su negocio.

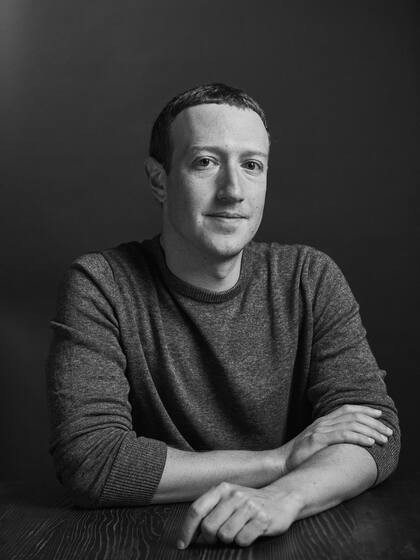

Durante años, Facebook ha estado bajo el escrutinio público por el contenido violento y de odio que fluye por toda su plataforma. Su director ejecutivo, Mark Zuckerberg, prometió en repetidas ocasiones que limpiará la red social. Zuckerberg promovió el uso de la inteligencia artificial para extirpar las publicaciones tóxicas y promociona sus esfuerzos para contratar a miles de trabajadores con el fin de que eliminen los mensajes que la inteligencia artificial no descarta.

Sin embargo, tras bambalinas, Facebook pagó de manera discreta a terceros para que asuman esa responsabilidad. Desde 2012, la empresa contrató al menos a diez consultorías y firmas de personal a nivel global para escudriñar sus publicaciones, junto con una red más amplia de subcontratistas, según entrevistas y registros públicos.

Ninguna empresa ha sido más crucial para ese esfuerzo que Accenture. La firma de la lista Fortune 500, mejor conocida por proveer servicios de tecnología de punta, contabilidad y consultoría a empresas multinacionales y gobiernos, se volvió el socio más importante de Facebook en la moderación de contenido, según un análisis realizado por The New York Times.

Un “cliente diamante”

Accenture aceptó el trabajo -y le dio una fachada de respetabilidad- porque Facebook firmó contratos de moderación de contenido y otros servicios con un valor de al menos 500 millones de dólares al año, según la revisión del Times. Accenture emplea a más de una tercera parte de las 15.000 personas a quienes supuestamente Facebook contrató para inspeccionar sus publicaciones. Además, aunque los acuerdos representan tan solo una pequeña fracción del ingreso total de Accenture, le ofrecen una importante línea vital hacia Silicon Valley. Dentro de Accenture, Facebook es conocida como un “cliente diamante”.

Sus contratos, sobre los cuales no se había informado antes, han redefinido los límites tradicionales de una relación de subcontratación o tercerización. Accenture absorbió las peores facetas de la moderación del contenido y se encarga de los problemas de contenido de Facebook. Como un costo de ese negocio, Accenture tuvo que enfrentar los problemas de salud mental que experimentan sus trabajadores por la revisión de las publicaciones. Luchó contra el activismo laboral cuando esos empleados presionan por mejores sueldos y beneficios. Y soportó el escrutinio público en silencio cuando los trabajadores se pronunciaron en contra de esa labor.

Esos problemas se han agravado debido a que Accenture tiene dificultades para seguir el paso a las demandantes metas de contratación, los objetivos de rendimiento de Facebook y los múltiples cambios en sus políticas sobre el contenido, según quince empleados y exempleados. Además, cuando los moderadores demandaron a la consultora por este trabajo, Accenture permaneció callada mientras Facebook argüía que no era responsable porque los trabajadores pertenecían a Accenture y otras empresas.

“Facebook no sería lo que es hoy en día sin Accenture”, comentó Cori Crider, cofundadora de Foxglove, un despacho jurídico que representa a los moderadores de contenido. “Por unos pagos impresionantes, los facilitadores como Accenture permitieron que Facebook se mantenga lejos del principal problema humano de su negocio”.

El Times entrevistó a más de 40 empleados y exempleados de Accenture y Facebook, abogados laborales y otras personas sobre la relación de las empresas, la cual también incluye trabajos de contabilidad y publicidad. La mayoría habló de manera anónima debido a acuerdos de confidencialidad y temor a represalias. El Times también revisó documentos, registros legales, así como documentos regulatorios de Facebook y Accenture.

Facebook y Accenture se rehusaron a que sus ejecutivos realizaran comentarios. Drew Pusateri, vocero de Facebook, mencionó que la empresa estaba al tanto de que la moderación de contenido “puede ser una tarea difícil, por eso trabajamos de cerca con nuestros socios para evaluar de manera constante cómo apoyar del mejor modo a estos equipos”.

Stacey Jones, vocera de Accenture, señaló que el trabajo era un servicio público “esencial para proteger a nuestra sociedad manteniendo seguro internet”.

Ninguna de las dos empresas mencionó a la otra por su nombre.

Publicaciones pornográficas

Buena parte del trabajo de Facebook con Accenture se refiere a la cuestión de la desnudez. En 2007, cada mes, se unían millones de usuarios a la red social… y muchos publicaban fotos de desnudos. Un acuerdo al que Facebook llegó ese año con Andrew Cuomo, quien era el fiscal general de Nueva York, le exigió a la empresa que debía bajar en 24 horas las publicaciones pornográficas que los usuarios denunciaran.

Los empleados de Facebook que vigilaban el contenido pronto fueron rebasados por el volumen de trabajo, según los miembros del equipo. Sheryl Sandberg, directora de operaciones de la empresa, y otros ejecutivos presionaron al equipo para que encontrara soluciones automatizadas para examinar el contenido, mencionaron tres personas que trabajaron en ese proyecto.

Facebook también comenzó a buscar opciones de subcontratación, comentaron. Contratar a un tercero era más barato que contratar a las personas directamente y brindaba beneficios tributarios y regulatorios, junto con la flexibilidad de crecer o reducirse con rapidez en regiones donde la empresa no tenía oficinas ni experiencia en el idioma. Sandberg ayudó a defender la idea de la subcontratación, mencionaron las fuentes, y la gerencia de nivel medio resolvió los detalles.

En 2011, Facebook estaba trabajando con oDesk, un servicio que contrataba a trabajadores independientes para revisar el contenido. Pero en 2012, después de que el sitio de noticias Gawker informó que a los trabajadores de oDesk en Marruecos y otros lugares se les pagaba tan solo 1 dólar por hora de trabajo, Facebook comenzó a buscar otro socio.

Así fue como Facebook contactó a Accenture. Anteriormente conocida como Andersen Consulting, la firma se había rebautizado como Accenture en 2001 después de una ruptura con la firma contable Arthur Andersen. Y quería ganar terreno en Silicon Valley.

En 2010, Accenture consiguió un contrato de contabilidad con Facebook. Para 2012, este se había expandido hasta incluir un convenio para moderar contenido, en particular fuera de Estados Unidos.

Ese año, Facebook envió a empleados a Manila, Filipinas, y Varsovia, Polonia, para capacitar a los trabajadores de Accenture con el fin de que examinaran las publicaciones, según dos exempleados de Facebook involucrados en el viaje. A los trabajadores de Accenture les enseñaron a usar el sistema de software de Facebook y los lineamientos de la plataforma para dejar contenido publicado, eliminarlo o someterlo a revisión.

“Tejón de miel”

Lo que inició como unas pocas decenas de moderadores de Accenture creció con rapidez. Para 2015, la oficina de Accenture en el área de la bahía de San Francisco había creado un equipo, con el nombre clave “Tejón de miel” (un mamífero muy valiente y luchador), tan solo para satisfacer las necesidades de Facebook, según exempleados. Accenture pasó de aportar 300 trabajadores en 2015 a 3000 en 2016. Son una mezcla de empleados de tiempo completo y contratistas, dependiendo del lugar y la tarea.

La firma pronto aprovechó su trabajo con Facebook para conseguir contratos de moderación con YouTube, Twitter, Pinterest y otras empresas, dijeron los ejecutivos. (Se proyecta que la industria de moderación de contenido digital alcance los 8800 millones de dólares el próximo año, según Everest Group, aproximadamente el doble del total de 2020). Facebook también otorgó contratos a Accenture en áreas como verificar cuentas de usuario falsas o duplicadas y monitorear cuentas de celebridades y marcas para garantizar que no se vean inundadas de maltrato.

Después de que las autoridades federales descubrieron en 2016 que agentes rusos habían utilizado Facebook para difundir publicaciones divisivas entre los votantes estadounidenses durante las elecciones presidenciales, la compañía aumentó el número de moderadores. Dijo que contrataría a más de 3000 personas, además de las 4500 que ya tenía, para vigilar la plataforma.

“Si vamos a construir una comunidad segura, debemos responder rápidamente”, dijo Zuckerberg en una publicación de 2017.

Al año siguiente, Facebook contrató a Arun Chandra, un exejecutivo de Hewlett Packard Enterprise, como vicepresidente de operaciones escaladas para ayudar a supervisar la relación con Accenture y otras empresas. Su división está supervisada por Sandberg.

Facebook también repartió el trabajo de moderación de contenido con otras firmas como Cognizant y TaskUs. Facebook ahora representa la tercera parte de la actividad comercial de TaskUs, equivalente a 150 millones de dólares al año, según documentos regulatorios.

El trabajo era desafiante. Aunque la inteligencia artificial elimina más del 90% del material inaceptable que pasa por Facebook e Instagram, los trabajadores subcontratados deben decidir si dejar las publicaciones que la inteligencia artificial no detecta.

Se asigna una calificación de rendimiento con base en la revisión correcta de las publicaciones según las políticas de Facebook. Si cometen errores más de un 5% de las veces, pueden ser despedidos, de acuerdo con empleados de Accenture.

Pero las reglas de Facebook sobre lo que era aceptable cambiaban constantemente, lo que generaba confusión. Cuando la gente usaba un emoji de gasolinera como jerga para vender marihuana, los trabajadores borraban las publicaciones por violar la política de contenido de la empresa sobre drogas. Luego, Facebook les dijo a los moderadores que no eliminaran las publicaciones, antes de volver a cambiar de opinión.

Facebook también modificó su tecnología de moderación, agregando nuevos atajos de teclado para acelerar el proceso de revisión. Pero las actualizaciones a veces se publicaban con poca antelación, lo que aumentaba los errores.

En mayo, Accenture facturó a Facebook por aproximadamente 1900 moderadores de tiempo completo en Manila; 1300 en Bombay, India; 850 en Lisboa; 780 en Kuala Lumpur, Malasia; 300 en Varsovia; 300 en Mountain View, California; 225 en Dublín; y 135 en Austin, Texas, según los registros de personal revisados por el Times.

Al final de cada mes, Accenture envió facturas a Facebook en las que detallaba las horas trabajadas por sus moderadores y el volumen de contenido revisado. Cada moderador estadounidense generó 50 dólares o más por hora para Accenture, dijeron dos personas con conocimiento de la facturación. En contraste, los moderadores en algunas ciudades de Estados Unidos recibían un sueldo inicial de 18 dólares la hora.

Costos psicológicos

Dentro de Accenture, los trabajadores comenzaron a cuestionar los efectos de ver tantas publicaciones de odio.

Accenture contrató a consejeros de salud mental para manejar las consecuencias. Izabela Dziugiel, una consejera que trabajaba en la oficina de Accenture en Varsovia, contó que les dijo a los gerentes en 2018 que estaban contratando a personas que no estaban preparadas para revisar el contenido. Su oficina manejó publicaciones de Medio Oriente, incluidas imágenes y videos horripilantes de la guerra de Siria.

“Simplemente contrataban a cualquiera”, dijo Dziugiel, quien anteriormente trató a soldados con trastorno de estrés postraumático. Ella dejó la firma en 2019.

En Dublín, en 2018, un moderador de Accenture que examinaba contenido de Facebook dejó una nota suicida en su escritorio, comentó un especialista en salud mental que estuvo involucrado en el episodio. El trabajador fue encontrado a salvo.

Joshua Sklar, un moderador radicado en Austin que renunció en abril, comentó que revisaba de 500 a 700 publicaciones por turno, entre ellas de personas muertas tras accidentes automovilísticos y videos de animales torturados.

“En un video que vi, había un tipo que se estaba grabando mientras violaba a una niñita”, comentó Sklar, quien describió su experiencia en una publicación interna que luego se volvió pública. “Fue simplemente espantoso”.

Si los trabajadores se pasaban por alto la cadena de mando de Accenture y se comunicaban directamente con Facebook sobre asuntos de contenido, se arriesgaban a ser reprendidos, agregó Sklar. Esto provocó que Facebook tardara más en enterarse sobre los problemas y cómo reaccionar frente a ellos, señaló Sklar.

Facebook señaló que cualquier persona dedicada a filtrar contenido podía presentar sus inquietudes.

En una audiencia legal celebrada en junio, otro exmoderador de Austin, Spencer Darr, mencionó que la labor le había exigido tomar decisiones inimaginables, como determinar si borrar el video de un perro que era desollado vivo o solo marcarlo como perturbador. “El trabajo de los moderadores de contenido es imposible”, comentó.

En 2018, Accenture introdujo WeCare, políticas que, según los especialistas en salud mental, limitaban su capacidad para tratar a los trabajadores. Sus títulos cambiaron a “monitores de bienestar” y se les indicó que no dieran evaluaciones ni diagnósticos psicológicos, sino que brindaran “apoyo a corto plazo” como salir a caminar o escuchar música tranquilizadora. Según la guía de Accenture de 2018, el objetivo era enseñarles a los moderadores “cómo responder frente a situaciones y contenido difíciles”.

Jones, de Accenture, señaló que la empresa estaba “comprometida a ayudar a la gente que hace este importante trabajo a tener éxito profesional y personal”. Los trabajadores pueden ver psicólogos externos.

Para 2019, el escrutinio de la industria estaba creciendo. Ese año, Cognizant señaló que iba a dejar de brindar el servicio de moderación de contenido después de que el sitio tecnológico The Verge describió los bajos salarios y los efectos en la salud mental de los trabajadores en una oficina de Arizona. Cognizant mencionó que la decisión le iba a costar al menos 240 millones de dólares en ingresos e iba a eliminar 6000 puestos de trabajo.

Debate interno

Más de un director ejecutivo de Accenture debatió sobre los negocios con Facebook. En 2017, Pierre Nanterme, el jefe de Accenture en ese momento, cuestionó la ética del trabajo y si se ajustaba a la estrategia a largo plazo de la empresa de brindar servicios con altos márgenes de ganancia y experiencia técnica, dijeron tres ejecutivos involucrados en las discusiones.

No se tomaron acciones. Nanterme murió de cáncer en enero de 2019.

Cinco meses después, Julie Sweet, abogada y ejecutiva de Accenture desde hace mucho tiempo, fue nombrada como directora ejecutiva. Pronto ordenó la revisión del negocio de la moderación, dijeron tres excolegas.

Los ejecutivos prepararon informes y debatieron cómo el trabajo se compara con otros oficios como ser un conductor de ambulancias. Se enviaron consultores para observar a los moderadores y sus gerentes.

La oficina en Austin, que abrió en 2017, fue seleccionada para una auditoría como parte de la revisión de Sweet. La ciudad también albergaba una oficina de Facebook y tenía grandes poblaciones de hablantes de español y árabe para leer publicaciones que no estaban en inglés. En su apogeo, la oficina de Accenture en Austin tenía unos 300 moderadores que analizaban las publicaciones de Facebook.

Pero algunos trabajadores se sintieron descontentos con el pago y con la visualización de tanto contenido tóxico. Organizándose a través de mensajes de texto y foros de mensajes internos, pidieron mejores salarios y beneficios. Algunos compartieron sus historias con los medios.

El año pasado, un trabajador de Austin fue uno de los dos empleados de Accenture que se unieron a una demanda colectiva contra Facebook presentada por moderadores estadounidenses. Facebook argumentó que no era responsable porque los trabajadores eran empleados de empresas como Accenture, según los registros judiciales. La red social alcanzó un acuerdo de 52 millones de dólares con los trabajadores en mayo de 2020.

Por Sweet, el debate en torno a los contratos de Facebook se extendió durante varias reuniones, según exejecutivos. Posteriormente, Sweet realizó varios cambios.

En diciembre de 2019, Accenture creó una divulgación legal de dos páginas para informar a los moderadores sobre los riesgos del puesto. El trabajo tenía “el potencial de impactar de manera negativa en su salud mental o emocional”, decía el documento.

En octubre pasado, Accenture fue más allá. En su reporte anual, por primera vez registró la moderación de contenido como un factor de riesgo, pues podía dejar a la firma vulnerable al escrutinio mediático y a problemas legales. Accenture también restringió a los nuevos clientes de moderación, según dos personas con conocimiento sobre el cambio de política. Cualquier nuevo contrato exigía la aprobación de la alta gerencia.

No obstante, Sweet también dejó algunas cosas inalteradas, según las personas.

Entre ellas: los contratos con Facebook. A final de cuentas, el cliente era demasiado valioso como para dejarlo.

The New York Times

Otras noticias de Estados Unidos

Más leídas de El Mundo

Tensión en Ucrania. EE.UU. y países europeos cierran sus embajadas en Kiev ante el riesgo de un “ataque aéreo significativo” de Rusia

Giro en la guerra. El mapa que muestra hasta dónde pueden llegar los misiles de largo alcance lanzados desde Ucrania hacia Rusia

Desregulación y ajuste. El abrupto giro a la derecha de Nueva Zelanda tras tener uno de los gobiernos más progresistas del mundo

1000 días de guerra. Ucrania, agotada: “Quizás vale la pena decir de acuerdo, tomen esta parte, pero déjennos en paz”