La prueba ARC-AGI mide cuántos ejemplos necesita ver un sistema de inteligencia artificial ante una situación nueva para poder entender cómo funciona. ChatGPT o3 se superó la mayor puntuación y obligó a los expertos a diseñar una nueva edición más compleja.

5 minutos de lectura'

5 minutos de lectura'

Además de los grandes logros que vemos a diario, sabemos con certeza la capacidad que tiene la inteligencia artificial debido a determinadas evaluaciones que hacen los profesionales a los diferentes modelos. En inglés, estas pruebas se llaman benchmarks, puntos de referencia a los cuales llega o, en el mejor de los casos, supera la nueva tecnología: es una forma de comparar en forma estandarizada el funcionamiento de uno u otro modelo de inteligencia artificial generativa.

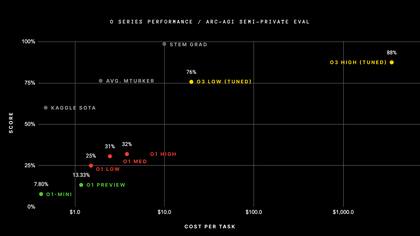

Uno de los tests más conocidos es el ARC-AGI, que anualmente organiza una competencia -ARC Prize- donde se premia al sistema de inteligencia artificial que logró el mayor puntaje. En 2024, el modelo o3 (low) de OpenAI superó en un 75,7% la máxima puntuación de la evaluación y el modelo o3 (high) en un 87,5%, coronándose como los modelos más avanzados.

“Las evaluaciones son una forma de saber dónde estamos parados y, en ese sentido, sí, sirven para anticiparnos a los riesgos“, explicó Julián Peller, líder de tecnología en Instituto Humai, un centro de educación tecnológica para toda Latinoamérica. “Son una medida de nuestra propia ingenuidad y nuestro propio asombro frente a la velocidad de avance. Muchas veces un benchmark parece que mide algo muy importante hasta que una IA lo sobrepasa y, a partir de ahí, comienza a parecer cada vez más naif y sencillo”, agregó.

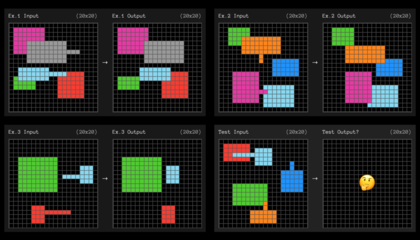

Según The Conversation, la prueba ARC-AGI fue creada en 2019 por el desarrollador de software francés François Chollet. Tras publicar su libro En la medida de la inteligencia, diseñó esta evaluación que, en términos técnicos, mide cuántos ejemplos necesita ver un sistema de inteligencia artificial ante una situación nueva para poder entender cómo funciona.

En la composición del nombre de la prueba se encuentran las siglas AGI, mejor conocida como la inteligencia artificial general. Esta última es una tecnología capaz de razonar como el ser humano y es la meta de todas las grandes empresas. Aunque la página oficial de ARC Prize afirmó que ellos no miden AGI, sí confirman que se dedican a encontrar las innovaciones que hacen los modelos. Que el o3 haya tenido una buena performance no significa que esté a la altura de la AGI.

Sin embargo, es evidente que la sofisticación que transitan los modelos es cada día mayor. Y las pruebas tienen que evolucionar a la par. “Los grandes modelos de lenguaje están entrenados sobre todo internet, haciendo que puedan haber consumido los mismos datos que se usan para evaluarlos y dificultando aún más la tarea de definir una buena evaluación”, comentó Peller. “Hoy se está intentando definir un horizonte de benchmarks que no quede obsoleto con la velocidad del progreso”, aseguró.

En este marco, en la próxima competición, los sistemas de inteligencia artificial tendrán que superar una nueva versión de la evaluación, la ARC-AGI-2, que promete ser más compleja. Aunque se presenta como una tarea difícil para las tecnologías, ante los ojos del humano es una prueba más bien sencilla. Lo que nos da la tranquilidad de que todavía corremos con ventaja. Ahora, ¿cuáles son sus diferencias con respecto a la edición pasada?

De acuerdo con GenBeta, en primer lugar está el aumento del número de tareas que va a tener que resolver, pasando de 100 a 120. Este distintivo busca que la tecnología pueda desenvolverse en una mayor diversidad y dificultad de retos. Y, en paralelo, se eliminaron todas aquellas tareas que la inteligencia artificial ya resolvía con facilidad. Es decir, que sacaba rápido por sus algoritmos predeterminados. Así, el foco está exclusivamente puesto en el desarrollo de la capacidad de razonamiento.

También incorporaron pruebas que abordan aspectos clave del pensamiento lógico, como la interpretación simbólica, el razonamiento composicional y la aplicación de reglas contextuales. Todos campos donde la inteligencia artificial no se destaca. Por ejemplo, los humanos podemos entender rápidamente el sarcasmo en una oración o identificar objetos que están semiocultos en imágenes. Los sistemas todavía muestran muchas limitaciones en eso.

Si bien estas evaluaciones son una forma de enterarnos los avances que van teniendo los modelos de lenguaje, también presentan una paradoja. Según Matías Grinberg, fundador y director del Instituto Humai, los expertos parten de una idea originaria que sostiene que hay una habilidad cognitiva que la inteligencia artificial no puede resolver y dentro del ámbito científico generan evaluaciones para medir algo abstracto como, por ejemplo, la creatividad.

“Al momento de plantear ese concurso se está de alguna manera operacionalizando esa tarea, ya que se da una definición precisa de lo que se propone como creatividad”, señaló Grinberg. “Lo que pasa es que a los pocos meses los sistemas superan ese puntaje, aunque haya un debate de si es creatividad en su esencia lo que se está midiendo. Nos encontramos, entonces, frente a nuestras propias limitaciones de definirnos como humanos todo el tiempo”, comentó.

Para Grinberg estos benchmarks no son tanto una “anticipación de riesgo”, sino que más bien suelen acelerar los avances de los sistemas en alguna dirección en particular. Además de que, por supuesto, nos permiten monitorear las mejoras de la inteligencia artificial en algunas destrezas particulares para debatirlas -algo en lo que la sociedad ya mostró interés.

“Me parece que el camino es profundizar la conciencia social sobre la relevancia de la IA en la sociedad, romper con una inercia de una especie de sentimiento antitecnológico”, reflexionó Peller. “Es un gran momento para dar vuelta la página y avanzar con una alfabetización tecnológica masiva mínima”, manifestó.

1

1¿Con la nuestra? Adorni, su esposa y la doble vara de la austeridad

2

2Negocio: un empresario se asoció con un fabricante chino y arma equipos a la mitad del precio del mercado

- 3

Brenda Gandini: su historia de amor con Gonzalo Heredia, su admiración por su mamá, Daniela Cardone y su infancia en Cipolletti con su papá

4

4Fin de una época: la Argentina selló la paz con los fondos buitre que tenían deuda en default de 2001