La herramienta puede detectar no solo si un escrito fue hecho con inteligencia artificial, sino que puede distinguir si fue hecho por ChatGPT o Gemini o LLaMA

4 minutos de lectura'

4 minutos de lectura'

Una nueva herramienta permite detectar escritos creados por IA e incluso puede predecir qué modelo de lenguaje los creó y diferenciar a ChatGPT, Gemini o LLaMa. Estos hallazgos podrían ayudar a identificar usos indebidos de estas plataformas, como usarlas para hacer trampas en la escuela o generar desinformaciones que se difunden en línea, también conocidas como fake news.

Los modelos de IA generativa como ChatGPT de OpenAI y Gemini de Google se están posicionando cada vez más rápido como herramientas para desarrollar todo tipo de tareas, entre las que se destaca la generación de textos e imágenes realistas que a menudo son indistinguibles del contenido creado por humanos. Ya cada vez es más normal ver imágenes de figuras públicas generadas por IA que se vuelven virales, o comentarios generados por IA en plataformas digitales. Esto está generando inquietudes sobre la credibilidad de ciertos contenidos y la legalidad de sus usos.

En este contexto, la sociedad civil y los responsables de las políticas públicas de varios países se están interesando cada vez más en definir formas para distinguir el contenido generado por IA del contenido creado por humanos. La Ley de IA de la UE, por ejemplo, contiene disposiciones que exigen a los usuarios de sistemas de IA que en determinados contextos revelen y etiqueten si su contenido es generado por IA, y disposiciones que exigen que las personas estén informadas cuando interactúan con sistemas de este tipo. La Ley de Autorización de Defensa Nacional (NDAA) de Estados Unidos para el año fiscal 2024 también contiene disposiciones en licitaciones “para evaluar la tecnología... para la detección y marca de agua de la inteligencia artificial generativa”. Sin embargo, se tratan de acciones aisladas en contextos limitados.

En este sentido, un hallazgo de los científicos de Hopkins genera un gran interés. En rigor, descubrieron que, así como las personas escriben con un estilo personal y con detalles individuales que las distinguen de otros escritores, lo mismo ocurre con la inteligencia artificial, incluidos programas de vanguardia como Chat GPT. El trabajo, que podría revelar qué programas son propensos al abuso y conducir a controles más fuertes, fue presentado recientemente en la Conferencia Internacional sobre Representaciones de Aprendizaje.

“Somos los primeros en demostrar que el texto generado por IA comparte las mismas características que la escritura humana, y que esto se puede utilizar para detectarlo de manera confiable y atribuirlo a modelos de lenguaje específicos”, dijo el autor Nicholas Andrews, científico investigador principal del Centro de Excelencia en Tecnología del Lenguaje Humano de Johns Hopkins.

La falta de herramientas consolidadas para detectar textos hechos por IA fue lo que impulsó el trabajo de los científicos de esta universidad, en particular del citado investigador Andrews, quien tenía un interés por combatir las desinformaciones luego de ver cómo se expandieron en la campaña presidencial de 2016 de Estados Unidos: “Quería que intentáramos crear una huella digital de alguien en línea y ver si esas huellas digitales se corresponden con alguna de las informaciones falsas que estamos viendo”, dijo. “Ahora tenemos esta herramienta que pasamos años construyendo y podemos aplicarla para detectar qué es falso y qué no está en línea. No solo eso, podemos averiguar si fue ChatGPT o Gemini o LLaMA, ya que cada uno tiene huellas digitales lingüísticas que los separan no solo de los autores humanos sino también de otros autores de máquinas”.

Uno de los hallazgos más importantes que les permitió detectar la nueva herramienta es que cada programa de escritura de IA tiene un estilo distinto. Si bien el equipo no es el primero en crear un sistema de detección de escritura con inteligencia artificial, su método parece ser el más preciso y ágil, ya que es capaz de responder rápidamente al cambiante panorama de la inteligencia artificial. De acuerdo al documento de trabajo publicado, los científicos analizaron textos en los que podían identificar incluso el tono y estilo de personalidad que los usuarios le pedían a la IA. Entre ellos identificaron estilos de lenguaje adolescente, de ciudadano preocupado, optimista escéptico, realista pragmático y activista apasionado, entre otros.

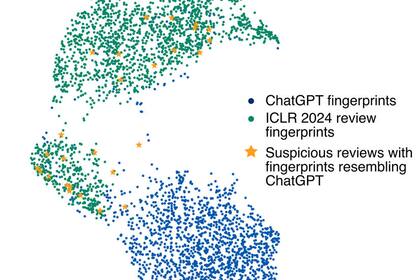

Cuando el equipo presentó los descubrimientos de su estudio lo hizo de una manera especial: con una demostración en vivo en la que solicitaron a sus pares todas las presentaciones para analizar por el detector. ¿El resultado? La herramienta demostró que aproximadamente el 10% de las revisiones probablemente habían sido generadas por máquinas y probablemente ChatGPT. Próximamente esperan poner la herramienta a disposición del público para que la misma se puede descargar y usar libremente.

Otras noticias de FuturIA

1

1Qué ver en Netflix: las mejores series y películas para ver este fin de semana largo

2

2Las tres frases que indican inmadurez emocional en las personas, según la IA

3

3Protagonizó un éxito de Disney, fue el gran amor de Liam Neeson y murió de la forma más trágica

- 4

Uruguay - Argentina: Thiago Almada hizo un golazo en el Centenario

Últimas Noticias

Según la IA. Las tres frases que indican inmadurez emocional en las personas

Increíble caso. El pequeño reino budista que revolucionó su economía con una inesperada decisión

“El 2024 fue un período de transición". Cuáles son las tendencias del mercado de celulares para este año en Argentina y en la región

Ahora para comentar debés tener Acceso Digital.

Iniciar sesión o suscribite